Искусственный интеллект у вас дома: 5 причин отказаться от Copilot и ChatGPT

- Категория: AI Технологии

- Дата: 9 августа 2025 г. в 23:20

- Просмотров: 218

Когда речь заходит об искусственном интеллекте (ИИ), большинство сразу вспоминает ChatGPT, Copilot, Google Gemini или Perplexity – популярные онлайн-чат-боты, которые постоянно на слуху. И это неудивительно, но ИИ – это гораздо больше, чем просто чат-боты.

ИИ может быть полезен во многих ситуациях, даже без подключения к интернету. Например, Copilot+ PC предлагают множество локальных функций благодаря нейронному процессору (NPU). Вы можете использовать ИИ для редактирования видео, транскрибирования аудио, запуска локальных больших языковых моделей (LLM) или даже просто для улучшения ваших встреч в Microsoft Teams.

В этой статье мы рассмотрим пять причин, по которым стоит обратить внимание на локальный ИИ, вместо того чтобы полагаться на онлайн-сервисы.

Важное замечание

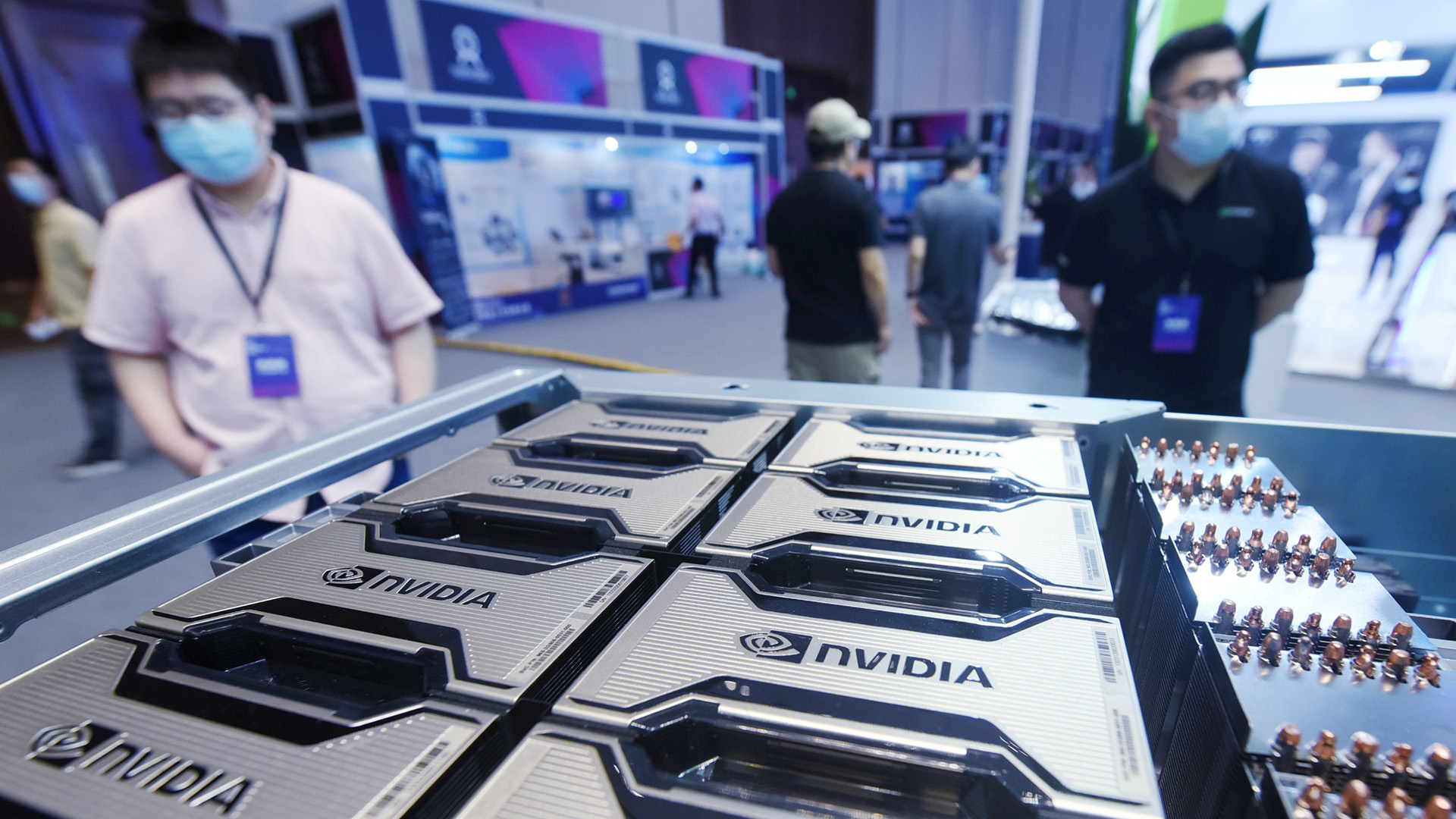

Прежде чем мы начнем, стоит упомянуть об одном важном моменте – аппаратном обеспечении. К сожалению, для запуска современных локальных LLM потребуется достаточно мощный компьютер.

Copilot+ PC, например, обладают множеством локальных функций благодаря встроенному NPU. Хотя NPU требуется не для всех задач ИИ, вычислительная мощность все равно необходима. Поэтому, прежде чем пытаться использовать какой-либо локальный инструмент ИИ, убедитесь, что ваш компьютер соответствует минимальным требованиям.

1. Работает без интернета

Это довольно очевидное преимущество. Локальный ИИ работает прямо на вашем компьютере. В отличие от ChatGPT и Copilot, которые требуют постоянного подключения к интернету, даже если у вас установлено приложение Copilot в Windows 11.

Конечно, сейчас, в 2025 году, связь стала намного лучше, чем раньше. Wi-Fi есть даже в самолетах. Но интернет все еще доступен не везде. Без подключения вы не сможете воспользоваться онлайн-инструментами. В то же время, вы можете запустить OpenAI gpt-oss:20b LLM на своем компьютере полностью в автономном режиме. Да, она может работать не так быстро, как последние модели (особенно учитывая недавний выход GPT-5, в то время как эта модель основана на GPT-4), но вы сможете использовать ее в любом месте и в любое время.

Это же относится и к другим инструментам, например, к генераторам изображений. Вы можете запускать Stable Diffusion в автономном режиме на своем ПК, в то время как для получения изображения из онлайн-инструмента вам потребуется подключение к сети. Инструменты ИИ в видеоредакторе DaVinci Resolve также работают локально, используя ресурсы вашего компьютера.

Таким образом, локальный ИИ – это портативное решение, которое дает вам полный контроль над своими данными. Вы не зависите от стабильности серверов, ограничений или условий обслуживания онлайн-сервисов. Кроме того, вам не придется беспокоиться о том, что компания изменит свою модель или закроет доступ к старым версиям, которые вам больше нравятся.

2. Конфиденциальность под контролем

Это вытекает из первого пункта, но является достаточно важным преимуществом, чтобы выделить его отдельно. Когда вы используете онлайн-инструмент, вы передаете свои данные на большой сервер в облаке. Недавний случай с ChatGPT (который, к счастью, был исправлен) показал, что сеансы пользователей при определенных условиях могли попадать в результаты поиска Google.

Используя онлайн-инструменты ИИ, вы теряете контроль над своими данными. В отличие от этого, локальный ИИ позволяет обрабатывать всю информацию на вашем компьютере. Это особенно важно, если вы работаете с конфиденциальными данными, где безопасность и приватность имеют первостепенное значение.

Даже если ChatGPT предлагает режим инкогнито, ваши данные все равно покидают ваш компьютер. Локальный ИИ гарантирует, что все останется в автономном режиме. Кроме того, с локальным ИИ гораздо проще соблюдать правила защиты данных и региональные нормативные требования.

Стоит помнить, что если вы случайно отправите LLM со своего компьютера куда-либо (например, в Ollama), вы поделитесь всеми внесенными изменениями. Аналогично, включение веб-поиска в локальной модели (например, gpt-oss:20b или 120b) также снизит уровень конфиденциальности.

3. Экономия и забота об окружающей среде

Для работы больших языковых моделей (LLM) требуется огромное количество энергии. Это справедливо как для онлайн-сервисов, таких как ChatGPT, так и для локального ИИ. Однако, используя локальный ИИ, вы можете контролировать свои расходы и снизить воздействие на окружающую среду.

У ChatGPT есть бесплатный тариф, но он не совсем бесплатный. Огромный сервер где-то обрабатывает ваши запросы, потребляя при этом огромное количество энергии. Энергопотребление ИИ и его влияние на экологию – это серьезная проблема, требующая решения.

Запуская LLM локально, вы берете все под свой контроль. В идеале, вы можете установить на крыше своего дома солнечные панели и подключить их к аккумулятору, который будет питать ваши компьютеры и игровые устройства. Это всего лишь пример, но он показывает суть.

Экономическую выгоду оценить еще проще. Бесплатные тарифы онлайн-инструментов хороши, но они никогда не дадут вам максимальную производительность. Именно поэтому OpenAI, Microsoft и Google предлагают платные тарифы с расширенными возможностями. Например, ChatGPT Pro стоит целых 200 долларов в месяц (2400 долларов или около 216 000 рублей в год) только за доступ к топовому тарифу. А при использовании OpenAI API вы платите в зависимости от объема потребления.

В то же время, вы можете запустить LLM на своем игровом компьютере. Например, если у вас есть видеокарта RTX 5080 с 16 ГБ VRAM, вы можете использовать ее для задач ИИ, когда не играете. Зачем платить больше, если у вас уже есть необходимое оборудование?

4. Интеграция LLM в рабочий процесс

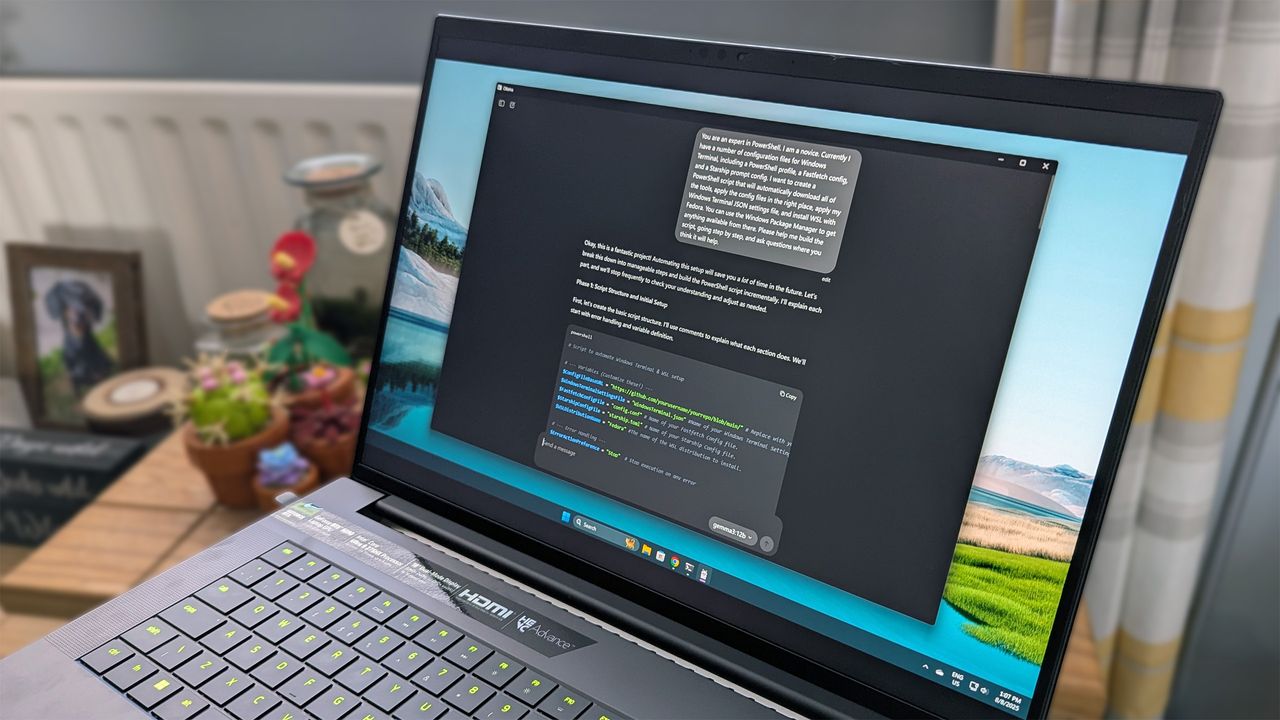

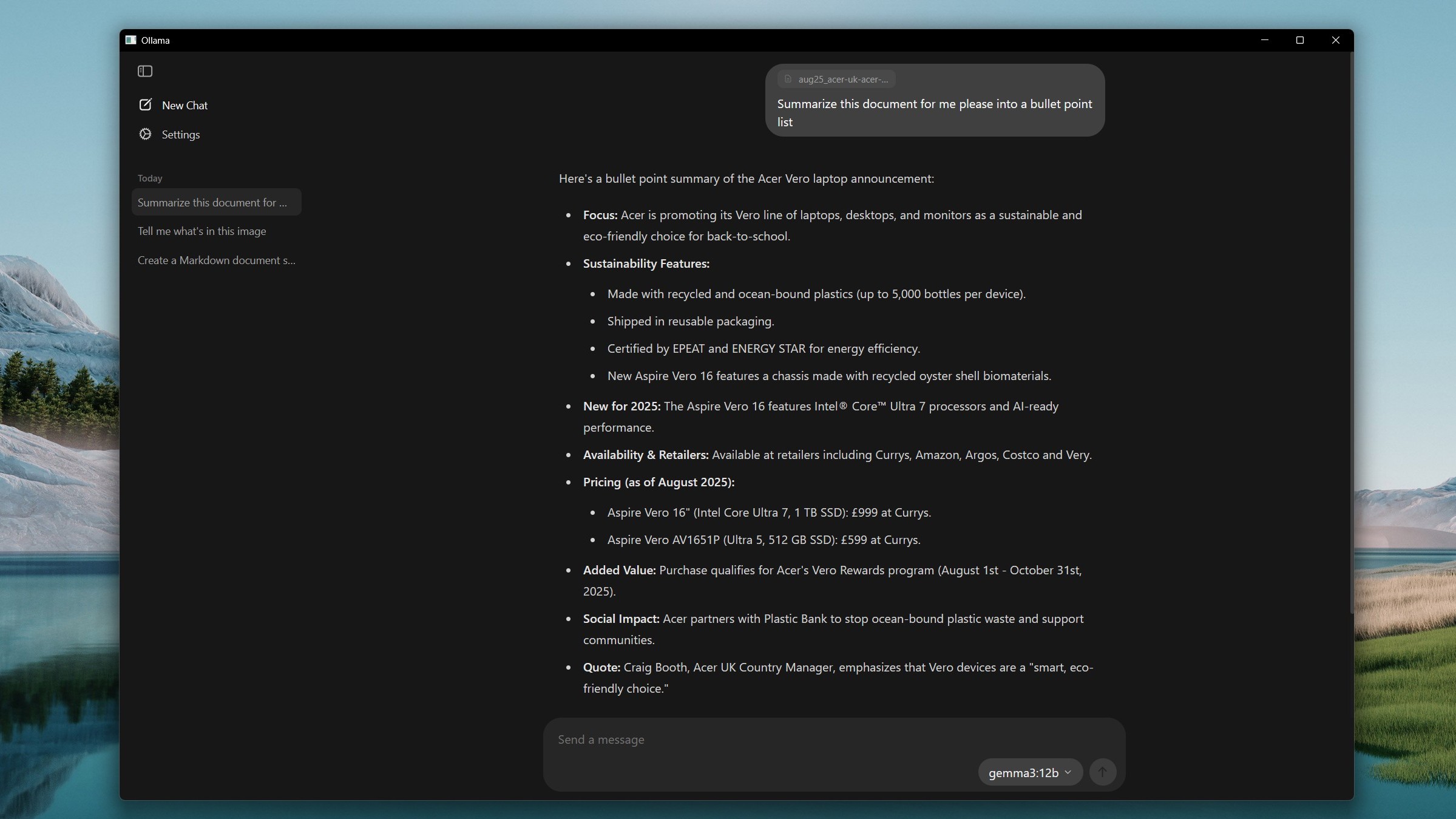

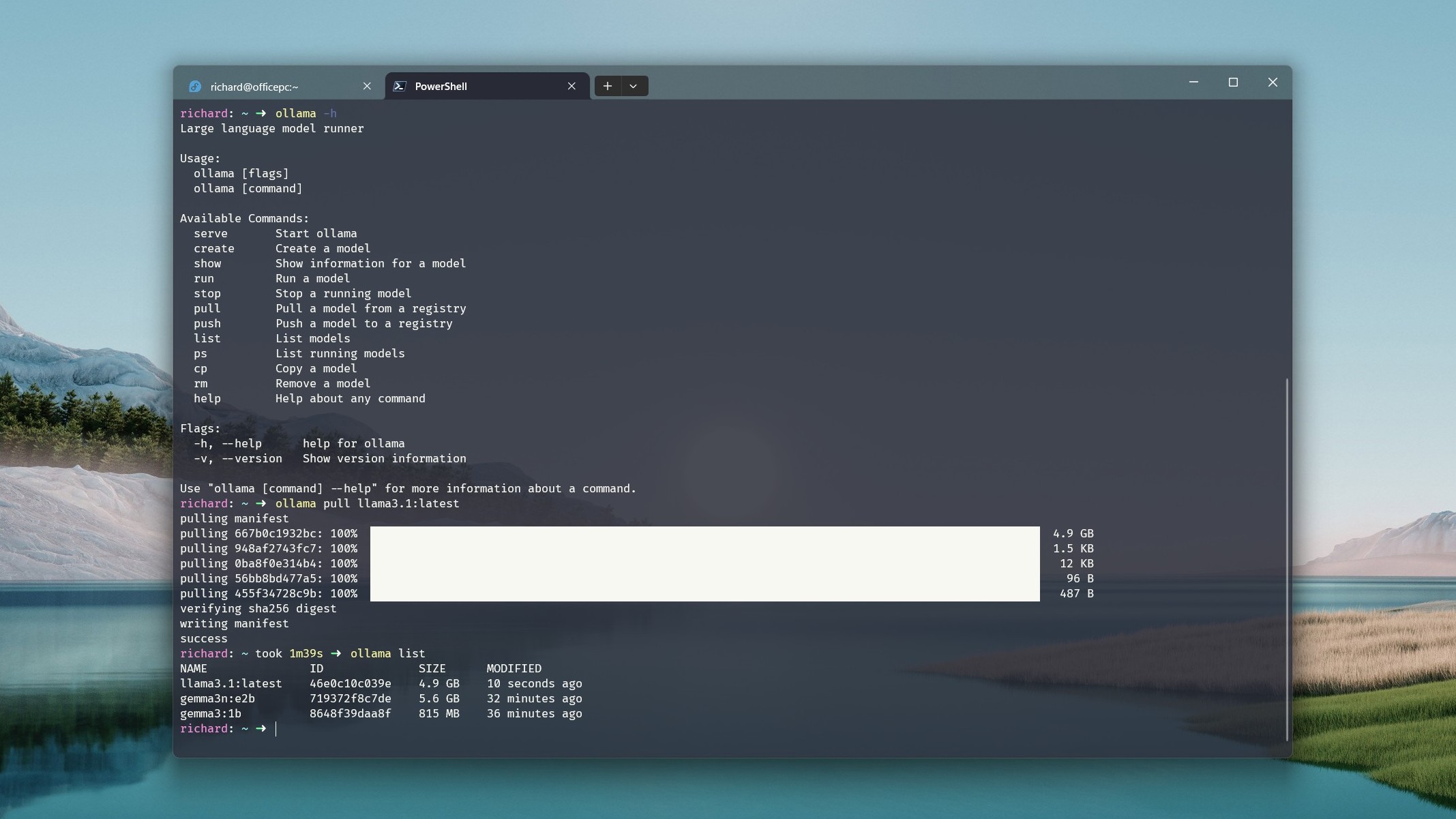

Я все еще только начинаю осваивать это, потому что я новичок в кодировании. Но с Ollama на моем ПК и LLM с открытым исходным кодом я могу интегрировать их с VS Code в Windows 11 и получить собственного помощника по кодированию с ИИ. И все это работает локально.

Это также связано с другими пунктами в этом списке. У GitHub Copilot есть бесплатный тариф, но он ограничен. Чтобы получить максимум, нужно платить. Кроме того, для его использования (как и для обычного Copilot, ChatGPT или Gemini) требуется подключение к интернету. Запуск локальной LLM решает все эти проблемы и позволяет лучше интегрировать ИИ в ваш рабочий процесс.

То же самое относится и к другим инструментам ИИ, не связанным с чат-ботами. Хотя я критически отношусь к тому, что Copilot+ недостаточно хорош, чтобы оправдать ажиотаж, его основная цель – использовать ресурсы вашего ПК для интеграции ИИ в вашу повседневную работу.

Локальный ИИ предоставляет вам большую свободу в выборе инструментов, которые лучше всего соответствуют вашим потребностям. Например, некоторые LLM лучше подходят для кодирования, чем другие. Используя онлайн-чат-бота, вы ограничены моделями, которые он предлагает. С локальной LLM у вас есть возможность настроить модель самостоятельно.

В конечном счете, локальные инструменты позволяют создать свой собственный рабочий процесс, адаптированный к вашим конкретным потребностям.

5. Обучение и развитие

Я говорю не о школьном образовании, а о самообразовании и развитии новых навыков. Вы можете узнать гораздо больше об ИИ, о том, как он работает и как его можно использовать, не выходя из дома.

ChatGPT кажется чем-то волшебным. Он может делать удивительные вещи, просто получив несколько слов в поле ввода. Это, безусловно, впечатляет, но гораздо полезнее узнать больше о том, как работает базовая технология. Какое оборудование и ресурсы ей нужны, как создать собственный сервер ИИ, как настроить LLM с открытым исходным кодом.

ИИ прочно вошел в нашу жизнь, и вы можете сделать гораздо больше, чем просто использовать готовые решения. Независимо от того, являетесь ли вы любителем или профессионалом, локальный ИИ дает вам свободу экспериментировать, использовать свои собственные данные и не зависеть от одной модели, облака или подписки.

Конечно, есть и недостатки. Если у вас нет очень мощного компьютера, производительность может стать проблемой. Вы можете легко запускать небольшие LLM локально и получать отличную производительность (например, Gemma, Llama или Mistral). Но самые большие модели с открытым исходным кодом, такие как новая gpt-oss:120b от OpenAI, не смогут нормально работать даже на самых современных игровых ПК.

Даже gpt-oss:20b будет работать медленнее (отчасти из-за своих возможностей рассуждения), чем ChatGPT на серверах OpenAI.

Кроме того, у вас не будет доступа к последним моделям (таким как GPT-5) сразу после их выхода. Есть исключения, например, Llama 4, которую вы можете скачать самостоятельно, но для ее запуска потребуется много ресурсов, пока не будут выпущены более компактные версии. У старых моделей также более старые данные.

Несмотря на все это, есть много веских причин попробовать локальный ИИ, вместо того чтобы полагаться на онлайн-альтернативы. В конечном счете, если у вас есть необходимое оборудование, почему бы не попробовать?

Мнение редакции MSReview: Локальный ИИ предоставляет пользователям беспрецедентный контроль над своими данными и вычислительными ресурсами. В то время как облачные решения, такие как Copilot и ChatGPT, предлагают удобство и доступность, локальный ИИ позволяет избежать зависимости от интернет-соединения, повысить конфиденциальность и снизить экологический след. Это особенно важно для пользователей, работающих с конфиденциальной информацией или желающих максимально оптимизировать свои ресурсы.

- Комментарии