Искусственный интеллект у вас дома: какую видеокарту выбрать для Ollama, не разорившись?

- Категория: AI Технологии

- Дата: 25 августа 2025 г. в 22:45

- Просмотров: 266

Искусственный интеллект (ИИ) перестал быть чем-то из фильмов — он прочно вошел в нашу жизнь. И дело не только в онлайн-сервисах вроде ChatGPT и Copilot. Если вы разработчик, энтузиаст или просто хотите понять, как это работает "изнутри", запуск ИИ локально на своем компьютере — отличный вариант.

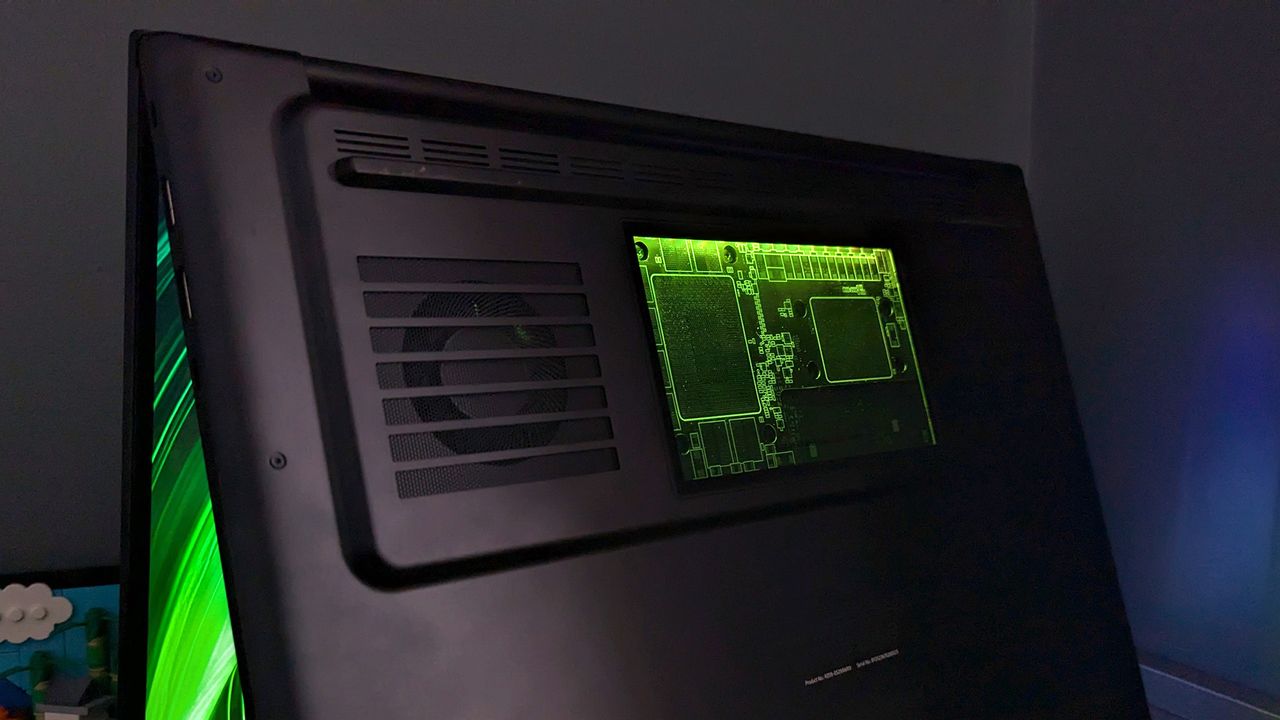

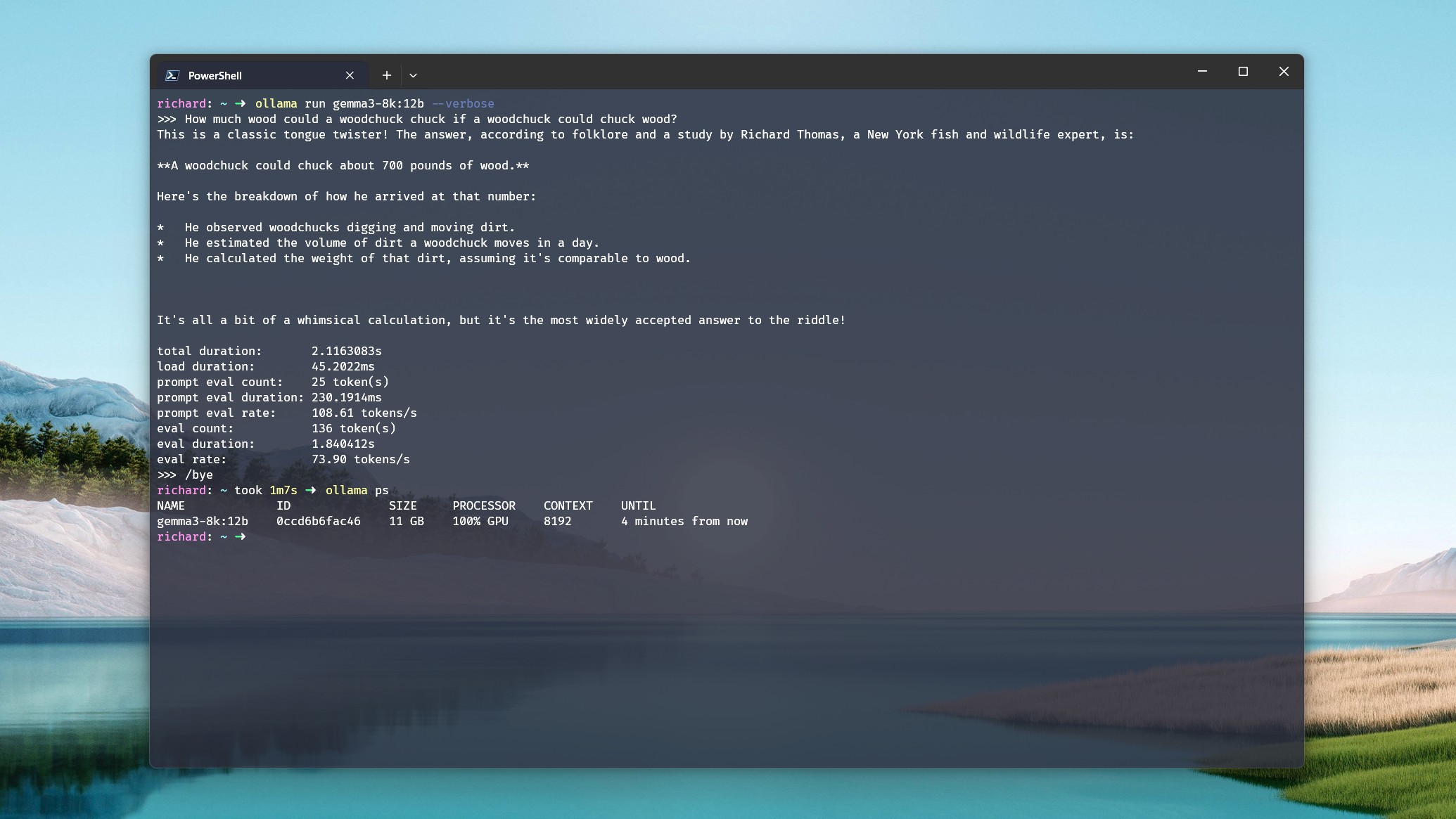

Ollama – один из самых простых и популярных способов экспериментировать с большими языковыми моделями (LLM) прямо на вашем компьютере. Но для этого вам понадобится кое-что, чего не требуется при использовании ChatGPT: достаточно мощное "железо". Особенно это касается Ollama, которая пока поддерживает только дискретные видеокарты. Впрочем, даже если вы используете LM Studio с поддержкой встроенных видеокарт, для комфортной работы вам все равно понадобится неплохая видеокарта.

Наверняка вы думаете, что для этого нужно выложить целое состояние? Вовсе нет! Конечно, можно купить RTX 5090 за баснословные деньги, но это совсем не обязательно. Отличных результатов можно добиться и с более старыми или бюджетными видеокартами. Если у вас завалялись лишние деньги на NVIDIA H100, это прекрасно, но есть способы намного дешевле.

VRAM – секрет успеха с Ollama

При выборе видеокарты для ИИ важны совсем другие параметры, чем при покупке видеокарты для игр. Для игр мы обычно выбираем самое новое и мощное, чтобы получить максимум графики и частоты кадров.

Конечно, при выборе "железа" для ИИ тоже хочется всего самого современного, но для домашнего использования это не так критично. Да, новейшие видеокарты 50-й серии могут похвастаться большим количеством ядер CUDA, более быстрыми вычислениями и высокой пропускной способностью памяти. Но главное – это объем видеопамяти (VRAM).

Если у вас нет неограниченного бюджета, ваш приоритет – это VRAM. Чем больше, тем лучше.

Когда центральному процессору (CPU) приходится брать на себя часть нагрузки (а в Ollama это неизбежно, когда видеопамяти не хватает), производительность падает.

Чтобы максимально эффективно использовать видеокарту с локальными LLM, нужно, чтобы используемая модель целиком помещалась в видеопамять. Во-первых, VRAM работает быстрее, чем оперативная память (RAM) компьютера. Во-вторых, если модель не помещается в VRAM и начинает использовать системную память, производительность резко падает. Когда CPU приходится брать на себя часть нагрузки (а в Ollama это неизбежно, когда видеопамяти не хватает), производительность падает.

Пример: модель Deepseek-r1:14b на компьютере с видеокартой NVIDIA RTX 5080 с 16 ГБ VRAM, процессором Intel Core i7-14700k и 32 ГБ оперативной памяти DDR5, на простой запрос "расскажи мне историю" выдает около 70 токенов в секунду с окном контекста до 16k. Если увеличить окно контекста, модель перестает помещаться в видеопамять и начинает использовать системную память и CPU.

В этом случае скорость вывода падает до 19 токенов в секунду, несмотря на то, что соотношение нагрузки CPU/GPU составляет 21%/79%. Даже если основную работу выполняет GPU, подключение CPU и RAM приводит к резкому падению производительности.

То же самое касается и ноутбуков. Если для вас важен ИИ, выбирайте ноутбук с видеокартой, у которой как можно больше VRAM.

Так сколько же VRAM нужно?

Короткий ответ: как можно больше. Лучший ответ: столько, сколько позволяет ваш бюджет. Но точный ответ зависит от того, какие модели вы хотите использовать.

На странице моделей на сайте Ollama для каждой модели указан ее размер. Это минимальный объем VRAM, который вам понадобится для загрузки модели в память видеокарты. Но для работы с моделью потребуется больше памяти. И чем больше окно контекста (чем больше информации вы передаете в LLM), тем больше памяти вам понадобится (так называемый KV cache).

В идеальном мире вам понадобится видеокарта с 24 ГБ VRAM, чтобы комфортно работать с этой моделью.

Многие рекомендуют умножить размер файла модели на 1,2, чтобы получить приблизительную цифру необходимой VRAM. Пример:

Размер модели gpt-oss:20b от OpenAI составляет 14 ГБ. Умножаем на 1,2 и получаем 16,8 ГБ. Опыт показывает, что это довольно точная цифра. Если запустить эту модель на RTX 5080 с 16 ГБ VRAM с окном контекста 8k или меньше, она будет полностью загружена в GPU.

При окне контекста 16k и выше начинают использоваться CPU и RAM, и производительность падает. Поэтому в идеале для комфортной работы с этой моделью вам понадобится видеокарта с 24 ГБ VRAM.

Повторимся: чем больше вы задействуете CPU и RAM, тем ниже будет производительность. Независимо от того, используете ли вы большие модели, большие окна контекста или и то, и другое, старайтесь, чтобы GPU работал как можно дольше.

Старые и недорогие видеокарты – отличный выбор для ИИ

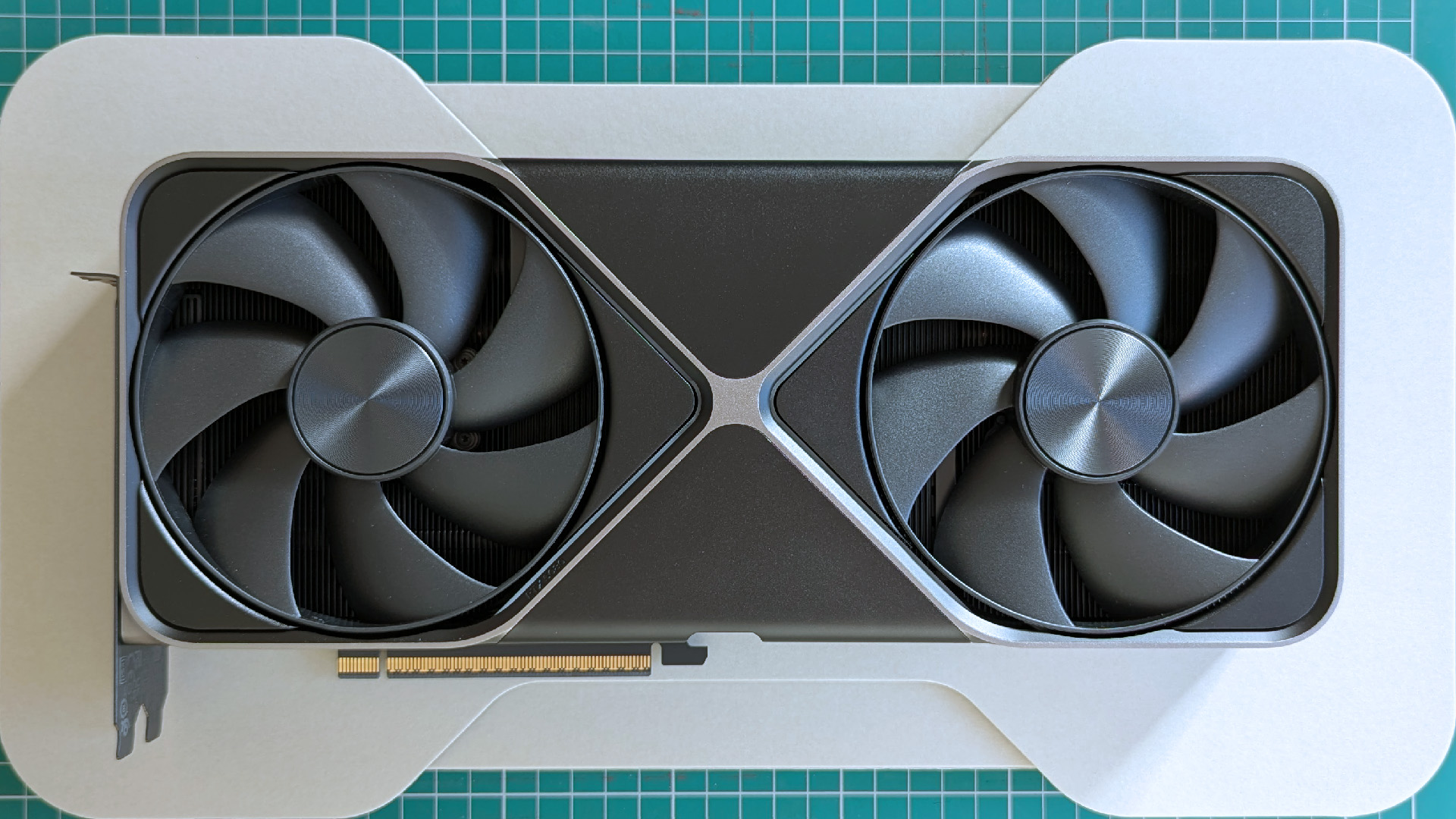

Поискав информацию в интернете, вы заметите одну закономерность. Многие считают, что RTX 3090 – лучший выбор для продвинутых пользователей на сегодняшний день, так как она сочетает в себе цену, объем VRAM и вычислительную мощность.

Если не учитывать разницу в архитектуре, RTX 3090 и RTX 5080 примерно одинаковы по количеству ядер CUDA и пропускной способности памяти. RTX 3090 превосходит RTX 5080 по объему VRAM – 24 ГБ против 16 ГБ. TDP (энергопотребление) RTX 3090 составляет 350 Вт, что значительно меньше, чем у RTX 4090 (24 ГБ) и RTX 5090 (32 ГБ). Очевидно, что последние будут работать лучше, но их покупка и эксплуатация обойдутся в целое состояние.

Есть и другой вариант. RTX 3060 – любимица сообщества ИИ благодаря 12 ГБ VRAM и относительно низкой цене. Пропускная способность памяти у нее значительно ниже, но и TDP составляет всего 170 Вт. Можно купить две такие видеокарты, и они будут соответствовать TDP и общему объему VRAM RTX 3090, при этом вы потратите гораздо меньше денег.

Многие утверждают, что RTX 3090 – лучший выбор для продвинутых пользователей на сегодняшний день.

Главное – вам совсем не обязательно бежать и покупать самую дорогую видеокарту. Важно найти баланс. Изучите информацию о моделях, с которыми вы хотите работать.

Затем определите свой бюджет и купите видеокарту с максимально быстрым и большим объемом VRAM, который вы можете себе позволить. Ollama позволяет использовать несколько GPU, поэтому, если две карты по 12 ГБ стоят дешевле, чем одна на 24 ГБ, это стоит рассмотреть.

И напоследок...

Если есть возможность, выбирайте NVIDIA. Ollama поддерживает ряд видеокарт AMD, но, честно говоря, на данный момент NVIDIA – лучший вариант для локального ИИ. "Красная команда" постоянно развивается, но NVIDIA пока вырвалась вперед.

У AMD есть свои сильные стороны, особенно в мобильных чипах для ноутбуков и мини-ПК. За цену одной из лучших видеокарт сегодня можно купить целый мини-ПК с APU Ryzen AI Max+ 395 поколения Strix Halo в сочетании со 128 ГБ унифицированной памяти и настоящей встроенной графикой Radeon 8060S десктопного класса.

Ollama не подойдет для такой системы или чего-либо еще, использующего чип Ryzen AI, поскольку она не поддерживает iGPU (интегрированную графику). Но LM Studio с поддержкой Vulkan подойдет. Система Strix Halo с объемом памяти 128 ГБ предоставляет вам до 96 ГБ памяти для выделения LLM, и это очень много.

Выбор есть, и есть варианты, которые не ударят по вашему кошельку. Проверьте свою будущую видеокарту на совместимость с Ollama. Если это карта старого поколения, берите как можно больше VRAM, даже если это означает покупку нескольких видеокарт. Пара RTX 3060 с 12 ГБ за 500-600 долларов (примерно 45 000 - 55 000 рублей) – это отличное начало.

Не позволяйте "железу" или бюджету остановить вас. Просто проведите небольшое исследование, чтобы получить максимальную отдачу от своих вложений.

- Комментарии