Забудьте про Ollama: LM Studio — ваш лучший выбор для локального ИИ на ноутбуке или мини-ПК. И вот почему

- Категория: AI Технологии

- Дата: 19 августа 2025 г. в 14:20

- Просмотров: 613

В последнее время я активно экспериментирую с запуском больших языковых моделей (LLM) прямо на своем компьютере. В основном я использовал для этого Ollama.

Ollama — отличный инструмент, который невероятно упрощает загрузку и запуск LLM на вашем ПК. С появлением нового графического интерфейса (GUI) этот процесс стал еще проще. Ollama может прекрасно интегрироваться в рабочий процесс, но у него есть один существенный недостаток.

Если у вас нет дискретной видеокарты, производительность оставляет желать лучшего. На компьютере с RTX 5080 (и скоро я попробую RTX 5090) все просто летает, но на чем-то вроде нового мини-ПК Geekom A9 Max, который только что прибыл для обзора, ситуация совсем иная.

Ollama официально не поддерживает интегрированную графику в Windows. По умолчанию он использует центральный процессор (CPU), и, честно говоря, иногда просто не хочется искать обходные пути.

И вот тут на сцену выходит LM Studio! Он позволяет использовать интегрированные графические процессоры (GPU) настолько просто, что даже я могу это сделать за считанные секунды. Это именно то, что нужно, и это причина, по которой вам стоит отказаться от Ollama, если вы хотите задействовать свой интегрированный GPU.

Что такое LM Studio?

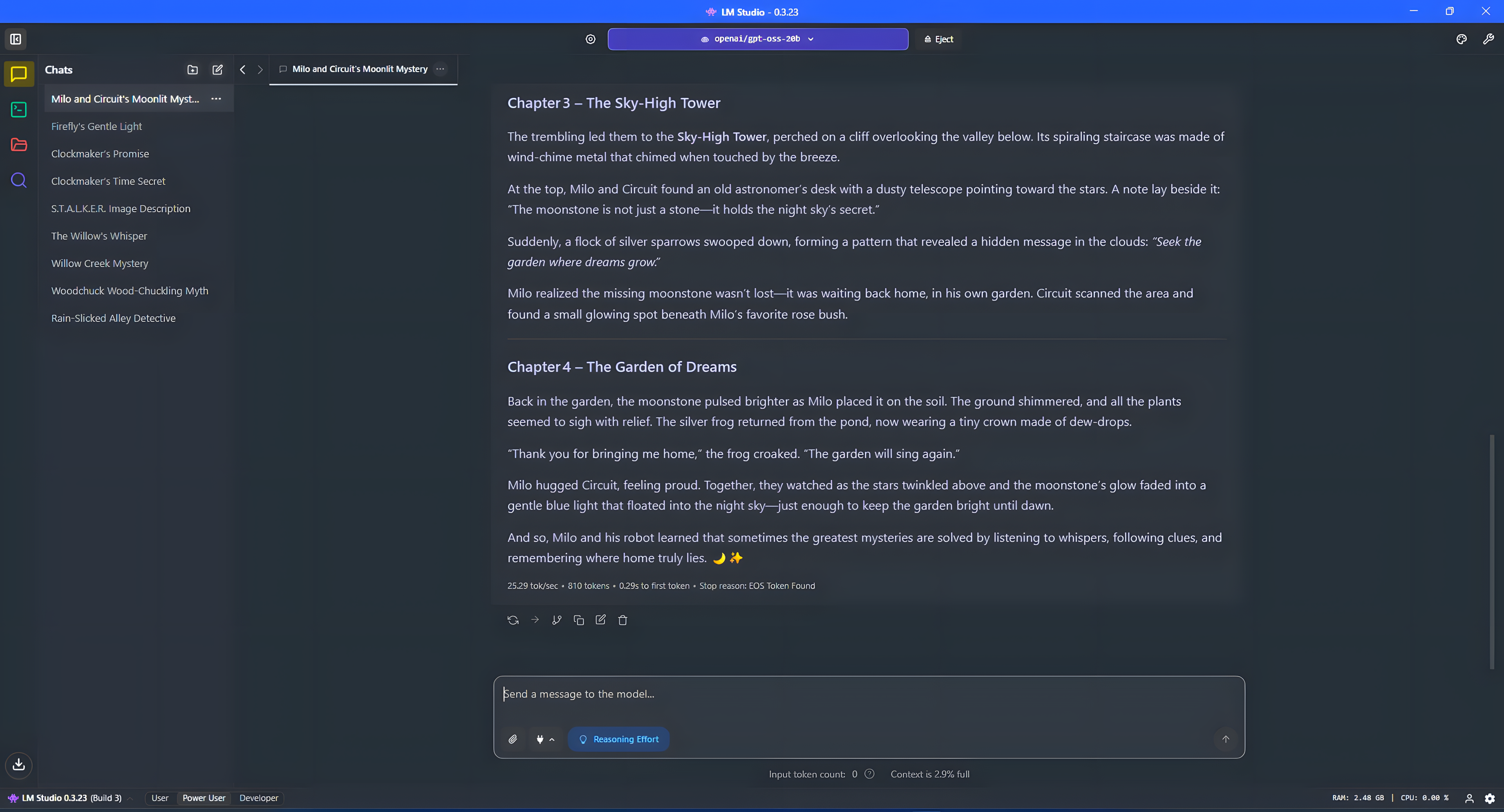

Производительность отличная для довольно большой модели, использующей мобильный AMD APU.

Если говорить простыми словами, LM Studio — это еще одно приложение, которое позволяет загружать и тестировать LLM на вашем компьютере с Windows. Он работает немного иначе, чем Ollama, но конечный результат тот же.

Кроме того, у LM Studio гораздо более продвинутый графический интерфейс, чем у официального приложения Ollama. Это еще один аргумент в его пользу. Чтобы получить максимум от Ollama, не используя терминал, вам понадобится что-то стороннее, например, OpenWebUI или расширение для браузера Page Assist.

В конечном счете, это универсальное решение для поиска и установки моделей, а также взаимодействия с ними через привычный интерфейс чат-бота. В LM Studio есть множество продвинутых функций, но пока что мы не будем углубляться в них.

Большим преимуществом LM Studio является поддержка Vulkan. Это означает, что вы можете перенести вычисления для моделей на интегрированные GPU от AMD и Intel. И это очень важно, потому что, как показывают мои тесты, использование GPU всегда быстрее, чем использование CPU.

Как использовать интегрированный GPU в LM Studio?

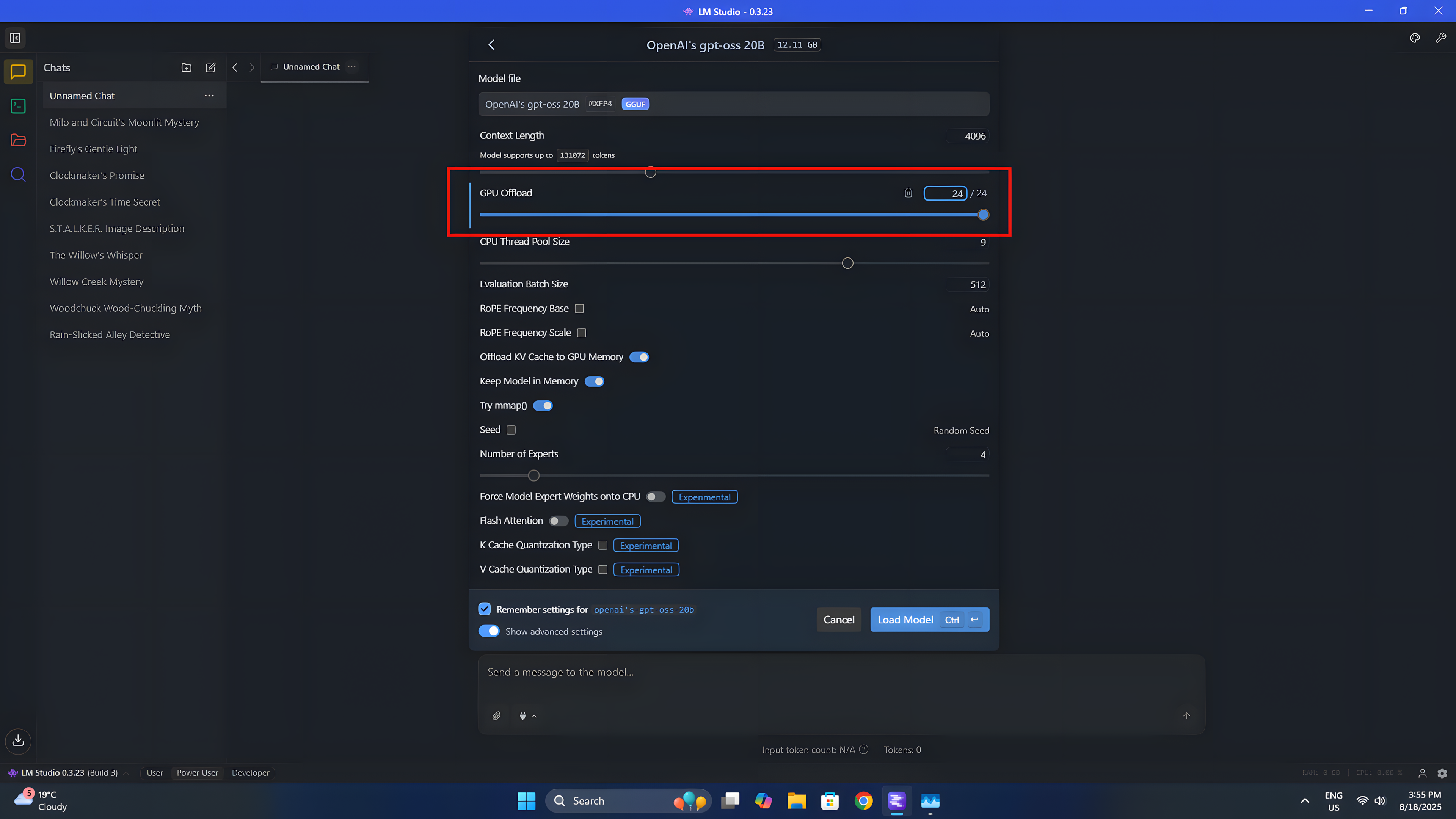

Чтобы убедиться, что вы используете свой iGPU, просто измените значение на этом ползунке.

Еще одно преимущество LM Studio — простота использования интегрированного GPU с LLM. Не нужно ничего сложного или требующего технических знаний.

Чтобы использовать модель, просто загрузите ее из выпадающего списка вверху. После выбора нужной модели появится множество настроек. В данном случае нас интересует только GPU offload (Разгрузка GPU).

Это скользящая шкала, которая работает послойно. Слои — это, по сути, блоки, из которых состоит LLM. Инструкции будут передаваться по ним один за другим, пока последний слой не выдаст ответ. Вы сами решаете, сколько слоев разгрузить на GPU, но если разгрузить не все, то ваш процессор будет выполнять часть работы.

Когда вы будете довольны настройками, нажмите «load model» (загрузить модель), и она загрузится в память и будет работать в рамках указанных вами параметров.

С LM Studio вы тоже можете быть так же счастливы, используя мини-ПК для локального ИИ!

Например, на вышеупомянутом Geekom A9 Max у меня интегрированная графика Radeon 890M, и я хочу использовать ее практически на полную мощность. Когда я использую ИИ, я не играю в игры, поэтому я хочу, чтобы весь GPU был сосредоточен на LLM. Я выделил 16 ГБ из моих 32 ГБ общей системной памяти, зарезервированных для GPU для загрузки модели, и приступил к работе.

С такой моделью, как gpt-oss:20b я могу загрузить все это в выделенную память GPU, использовать GPU для вычислений, оставить остальную системную память и CPU в покое и получить около 25 токенов в секунду.

Так же ли это быстро, как мой настольный ПК с RTX 5080 внутри? Вовсе нет. Быстрее ли это, чем использование CPU? Безусловно. С тем дополнительным преимуществом, что он не использует почти все мои доступные ресурсы CPU, ресурсы, которые может захотеть использовать другое программное обеспечение на ПК. GPU в основном бездействует большую часть времени; почему бы вам не захотеть использовать его?

Вероятно, я мог бы добиться еще большей производительности, если бы потратил время на углубление в детали, но это не главное. Основное внимание уделяется LM Studio и тому, как, если у вас нет выделенного GPU, это лучший инструмент для локальных LLM. Просто установите его, и все заработает.

Мнение редакции MSReview: LM Studio действительно является отличным решением для тех, у кого нет мощной дискретной видеокарты. Возможность использовать интегрированную графику значительно повышает производительность локальных LLM на ноутбуках и мини-ПК. Простота настройки и использования также являются важными преимуществами LM Studio по сравнению с другими решениями.

- Комментарии