Локальный ИИ против Copilot: сможет ли он заменить мою любимую функцию?

- Категория: AI Технологии

- Дата: 21 августа 2025 г. в 14:45

- Просмотров: 267

В современном мире, где время – самый ценный ресурс, умение быстро обрабатывать большие объемы информации становится критически важным. Будь то чтение новостей, изучение исследований или поиск конкретных данных, нам приходится ежедневно просматривать огромное количество контента.

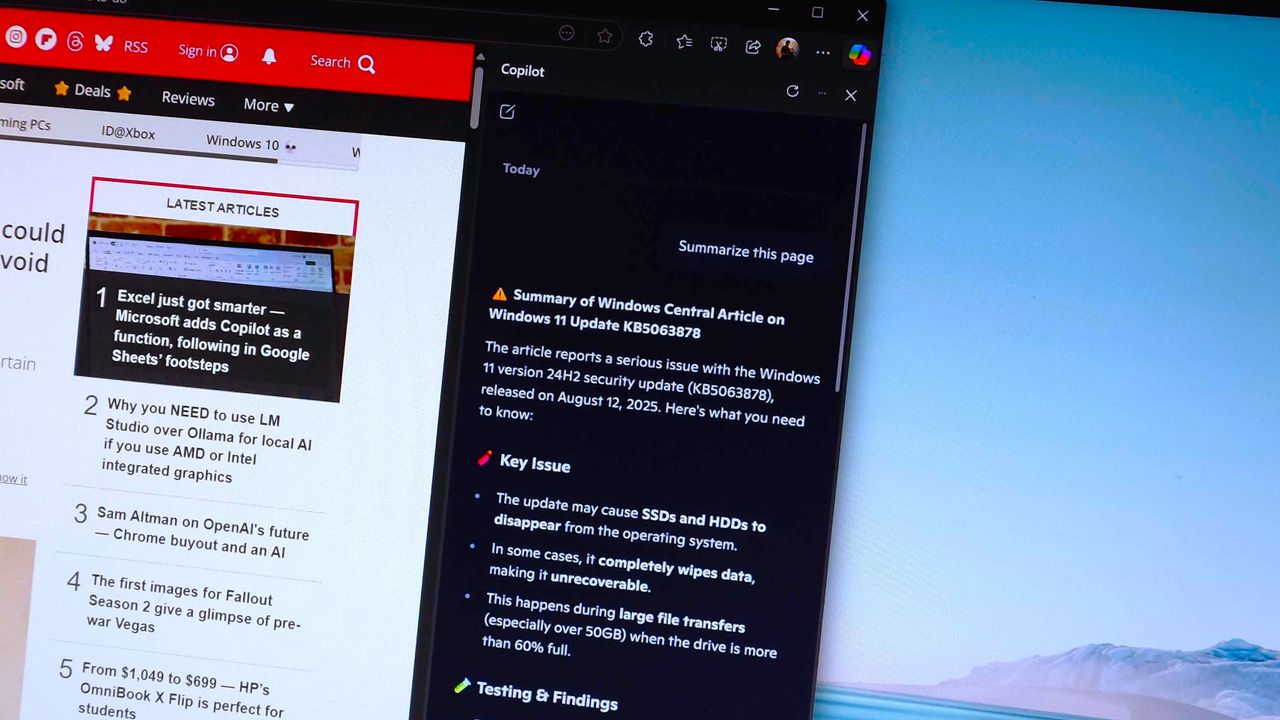

Copilot отлично справляется с созданием кратких обзоров, и с каждым днем он становится только лучше. Раньше мне приходилось подробно указывать, что именно я ищу и в каком формате хочу получить информацию. Теперь же он просто делает это сам, и делает это превосходно.

Однако в последнее время я активно экспериментирую с локальными ИИ, такими как Ollama и LM Studio, чтобы меньше зависеть от Copilot, ChatGPT и Google Gemini.

Многие методы реализации этой функции связаны с использованием Python. И хотя я не против небольших изменений, мне хотелось найти простое решение на основе браузера, которое могло бы выполнять нужную мне задачу.

Хорошая новость в том, что я кое-что нашел. Плохая новость – пока это не так хорошо, как Copilot.

Ollama в качестве бэкенда и Page Assist в качестве фронтенда

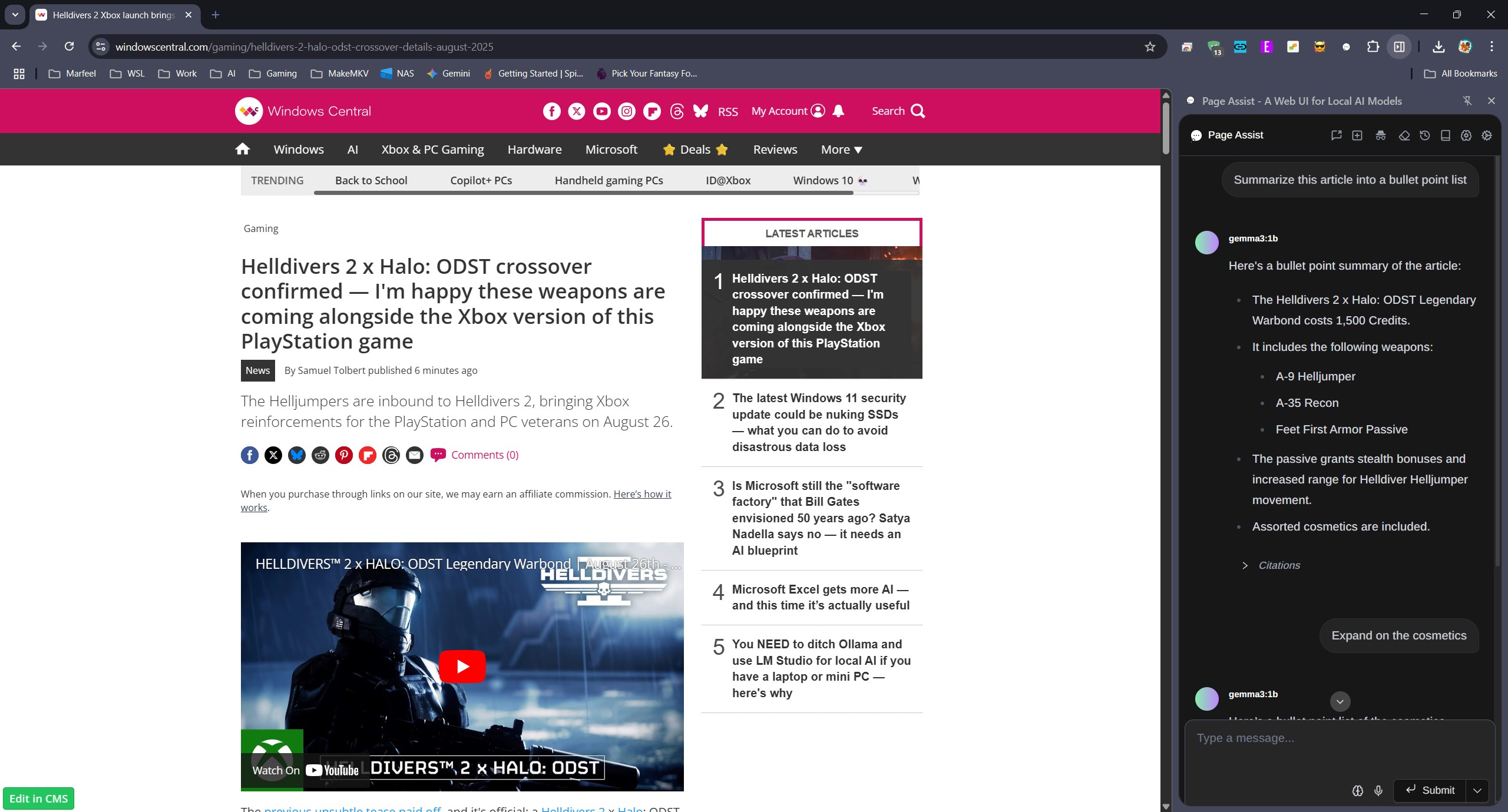

В поисках решения я наткнулся на Page Assist, расширение для браузера, доступное в Chrome Web Store (или Microsoft Edge Addons, если предпочитаете). Это не просто расширение, а полноценное веб-приложение, выступающее в роли графического интерфейса для Ollama.

Этот инструмент невероятно полезен и многофункционален. Возможно, в нем чего-то и не хватает, но я пока не обнаружил. Он значительно упрощает взаимодействие и управление локальными LLM, предлагая более продвинутые возможности, чем официальное приложение Ollama.

Хотя полный интерфейс меня не слишком интересует, возможность взаимодействия с открытой веб-страницей через боковую панель – это то, что я искал!

Чтобы Page Assist мог взаимодействовать с веб-страницей, необходим RAG (Retrieval-Augmented Generation).

Retrieval-Augmented Generation (RAG) – это метод, позволяющий ИИ извлекать информацию из внешних источников и использовать ее для генерации ответов. Если вы хотите узнать больше об этом, в интернете есть множество статей, например, вот эта от IBM.

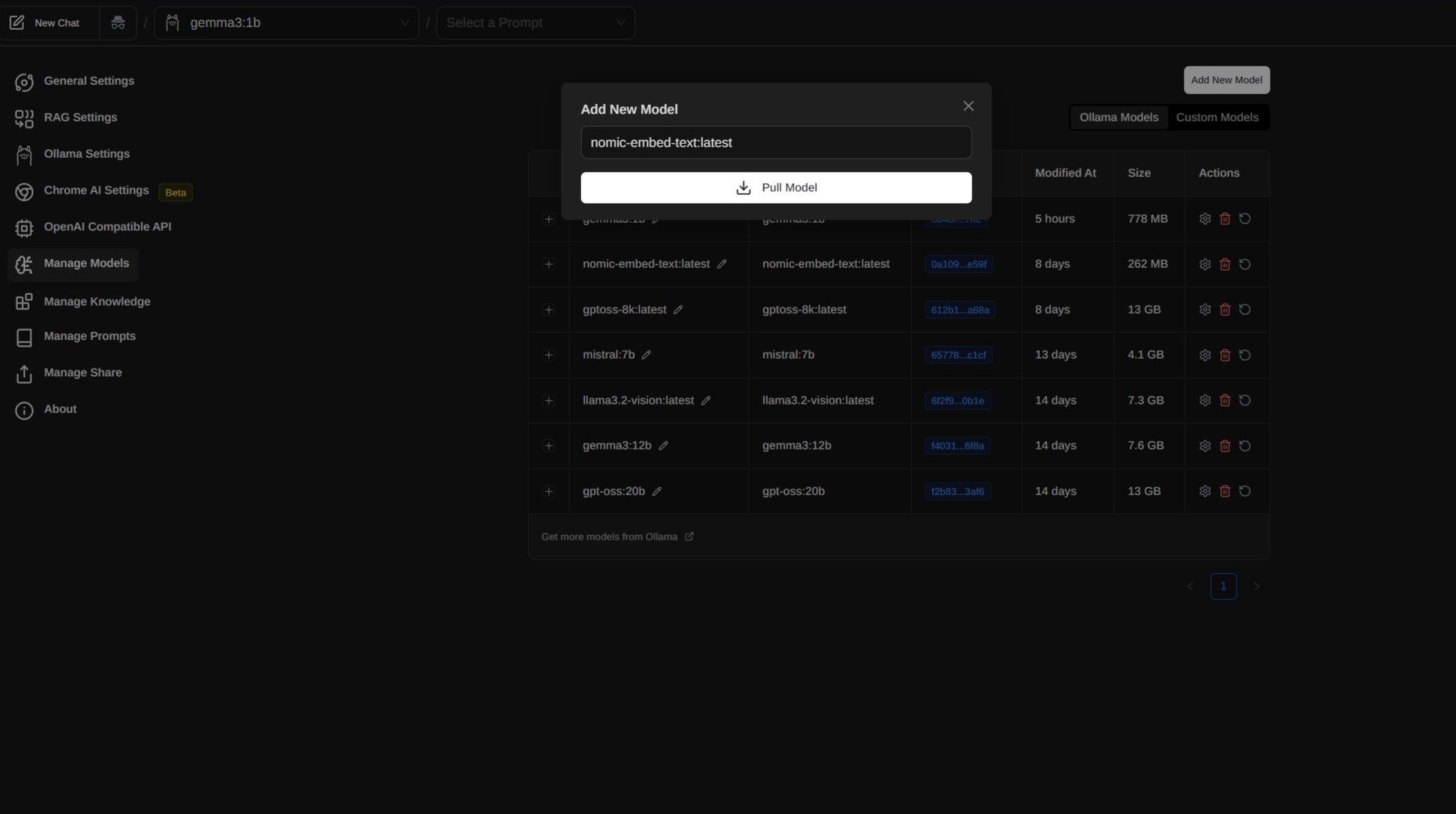

Для использования Page Assist для работы с веб-страницей нам нужна модель внедрения, встроенная в Ollama. Приложение упрощает этот процесс, рекомендуя Nomic Embed. Я установил ее прямо из Page Assist, используя меню Manage Models в Settings, добавив новую модель и введя nomic-embed-text:latest в соответствующее поле.

Последний шаг – запуск боковой панели. По умолчанию она доступна в меню правой кнопки мыши. Перейдите на страницу, с которой хотите взаимодействовать, щелкните правой кнопкой мыши и откройте боковую панель для чата.

Хорошо, но Copilot лучше

Работает ли это? Да, работает. Но, к сожалению, не так хорошо, как Copilot.

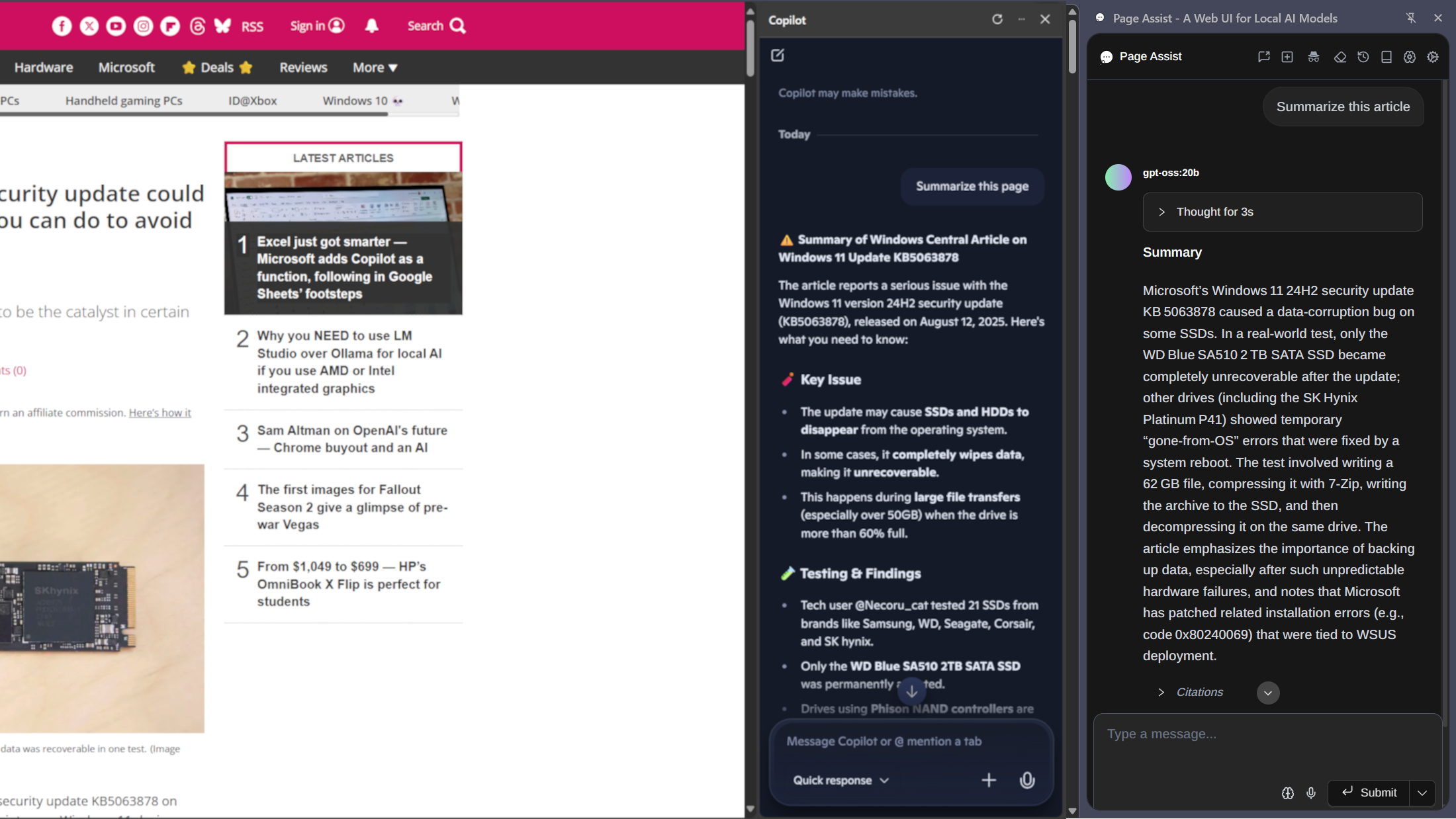

Начну с положительных моментов. Используя различные модели для тестирования, я действительно могу суммировать статьи. Чем больше модель, тем лучше она справляется со своей задачей. Очевидно, что gemma3:1b не может сделать столько же, сколько gpt-oss:20b. Но она выполняет то, что я прошу, обобщая веб-статьи.

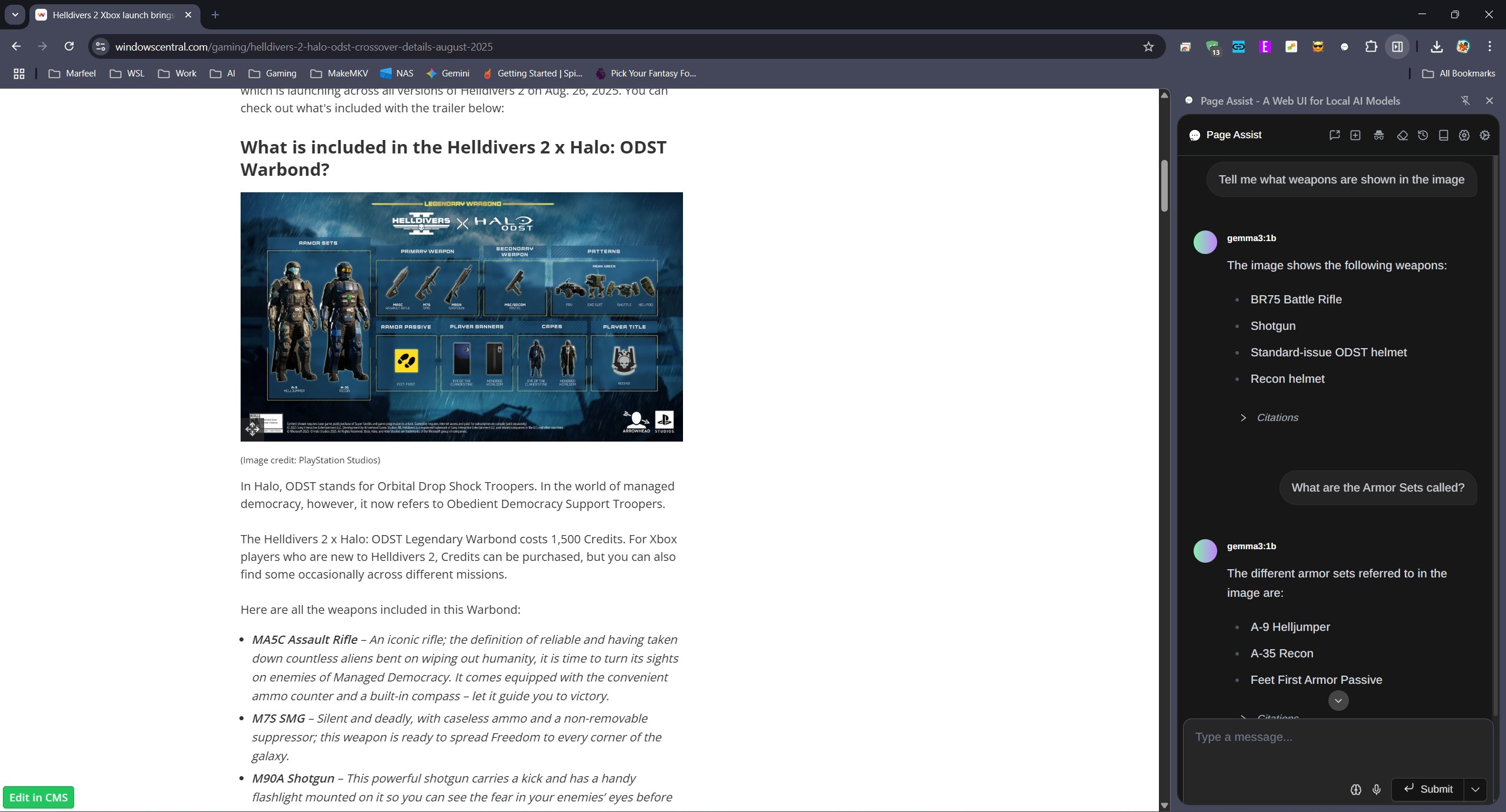

Он также может использовать зрение для анализа изображений, если вы загрузите модель с этой возможностью. Возможно, мне не стоило использовать такую маленькую модель, как показано на изображении выше. Но он прекрасно видит изображения, использует OCR и все такое.

Пока все хорошо. Но самая большая проблема в том, что, похоже, он не распознает, когда вы переходите с одной веб-страницы на другую. Я работаю так: если я нахожусь в режиме быстрого чтения, я оставляю боковую панель открытой и просто перезапускаю запрос при переходе со страницы на страницу.

Если я не начинаю новый чат или не заставляю модель забыть предыдущую статью и суммировать новую, он продолжает повторяться, основываясь на том, что он видел в предыдущей. Это не критично, но раздражает.

Какую бы модель я ни пробовал, она просто не дает такого же качественного анализа, как Copilot. Мне нужно получить резюме, но Copilot просто дает лучшее резюме без необходимости в очень конкретном запросе.

Уверен, со временем я мог бы добиться лучших результатов, но это требует времени и усилий. А в данном случае важна скорость и удобство. Copilot гораздо более разговорчив, а локальные модели кажутся очень конкретными.

Еще одно преимущество Copilot – он предлагает несколько последующих вопросов. Я не всегда использую их, но иногда они наводят меня на мысли, о которых я раньше не думал.

Пока остаюсь с онлайн-ИИ

Существует несколько веских причин для использования локального ИИ вместо онлайн-аналогов. Однако в данном случае мне все равно нужно быть онлайн, чтобы читать веб-страницы, которые я хочу суммировать. Так что, пока локальный ИИ не работает так же хорошо, как Copilot, нет причин отказываться от последнего.

Я все же призываю людей присмотреться к локальному ИИ. На данный момент это отличный способ получить новые знания и навыки. Каждый день я узнаю что-то новое.

В процессе экспериментов, описанных в этой статье, я нашел новый способ использования Ollama. Page Assist – отличный инструмент, и я, вероятно, напишу о нем подробнее в будущем, после того как изучу его возможности более глубоко.

Но пока я работаю, думаю, что буду придерживаться онлайн-инструментов для этой задачи. По крайней мере, на данный момент.

Мнение редакции MSReview: Несмотря на привлекательность локальных ИИ-решений с точки зрения конфиденциальности и контроля, они пока не дотягивают до продвинутых онлайн-инструментов, таких как Copilot, особенно в отношении скорости, удобства и качества суммирования. По мере развития технологий этот разрыв может сократиться, но на данный момент онлайн-ИИ остается лучшим выбором для многих задач, требующих быстрой и точной обработки информации.

- Комментарии