Прорыв в мире искусственного интеллекта: китайская разработка в 100 раз быстрее ChatGPT?

- Категория: AI Технологии

- Дата: 12 сентября 2025 г. в 14:50

- Просмотров: 230

В то время как в середине 20-го века мир завороженно следил за космической гонкой, сегодня мы являемся свидетелями не менее захватывающего соревнования – гонки в сфере искусственного интеллекта. Разработчики по всему миру стремятся сделать следующий большой шаг, и вот – громкое заявление из Китая.

Как сообщает издание The Independent, китайские ученые представили SpikingBrain1.0 – новую большую языковую модель (LLM). Казалось бы, ничего необычного, но, по словам разработчиков, эта модель в 100 раз быстрее, чем такие современные решения, как ChatGPT и Copilot. В чем же секрет?

Все дело в совершенно новом подходе к работе модели, который позиционируется как первый "мозгоподобный" LLM. Давайте разберемся, что это значит. Но сначала немного о том, как работают LLM нынешнего поколения.

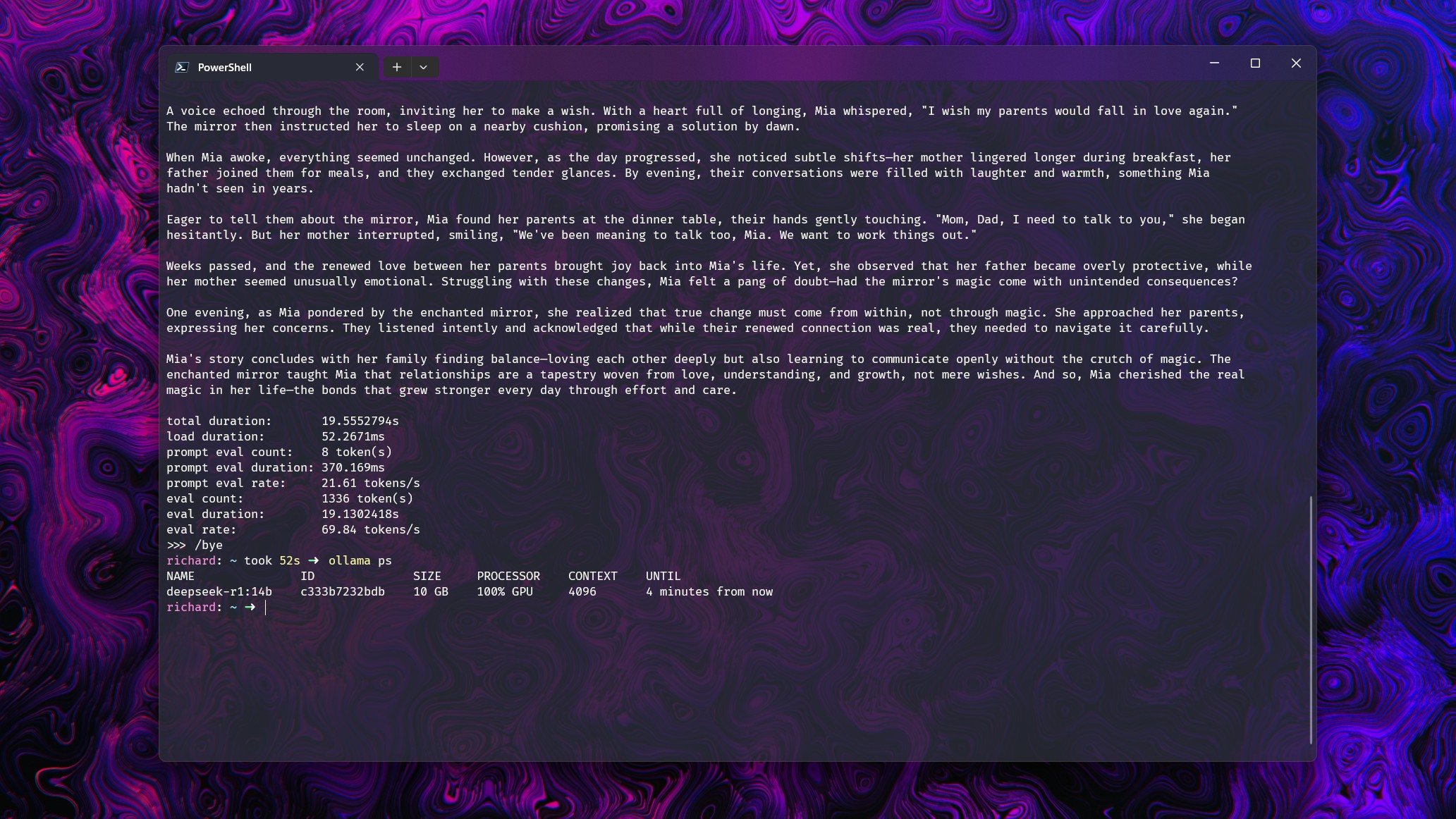

Нынешнее поколение LLM работает совсем не так, как SpikingBrain1.0 (Изображение: Windows Central)

Постараюсь объяснить максимально просто. Современные LLM анализируют все слова в предложении одновременно. Они ищут закономерности и взаимосвязи между словами, не обращая внимания на их порядок.

В основе этого подхода лежит механизм, известный как "Внимание" (Attention). Представьте себе предложение:

"Бейсболист взмахнул битой и выбил хоумран."

Человек, читая это предложение, мгновенно понимает его смысл, потому что мозг автоматически связывает "Бейсбол" с последующими словами. Но для LLM слово "бита" само по себе может означать как спортивный инвентарь, так и животное. Не проанализировав остальную часть предложения, модель не сможет сделать правильный выбор.

Механизм "Внимание" заставляет LLM просматривать все предложение целиком, чтобы установить связи между словами и понять его смысл. Он определяет другие термины, такие как "взмахнул" и "бейсболист", чтобы выбрать правильное значение слова "бита" и сделать более точный прогноз.

Это возможно благодаря огромному объему данных, на которых обучается LLM, где модель узнает, что "бейсбол" и "бита" часто встречаются вместе.

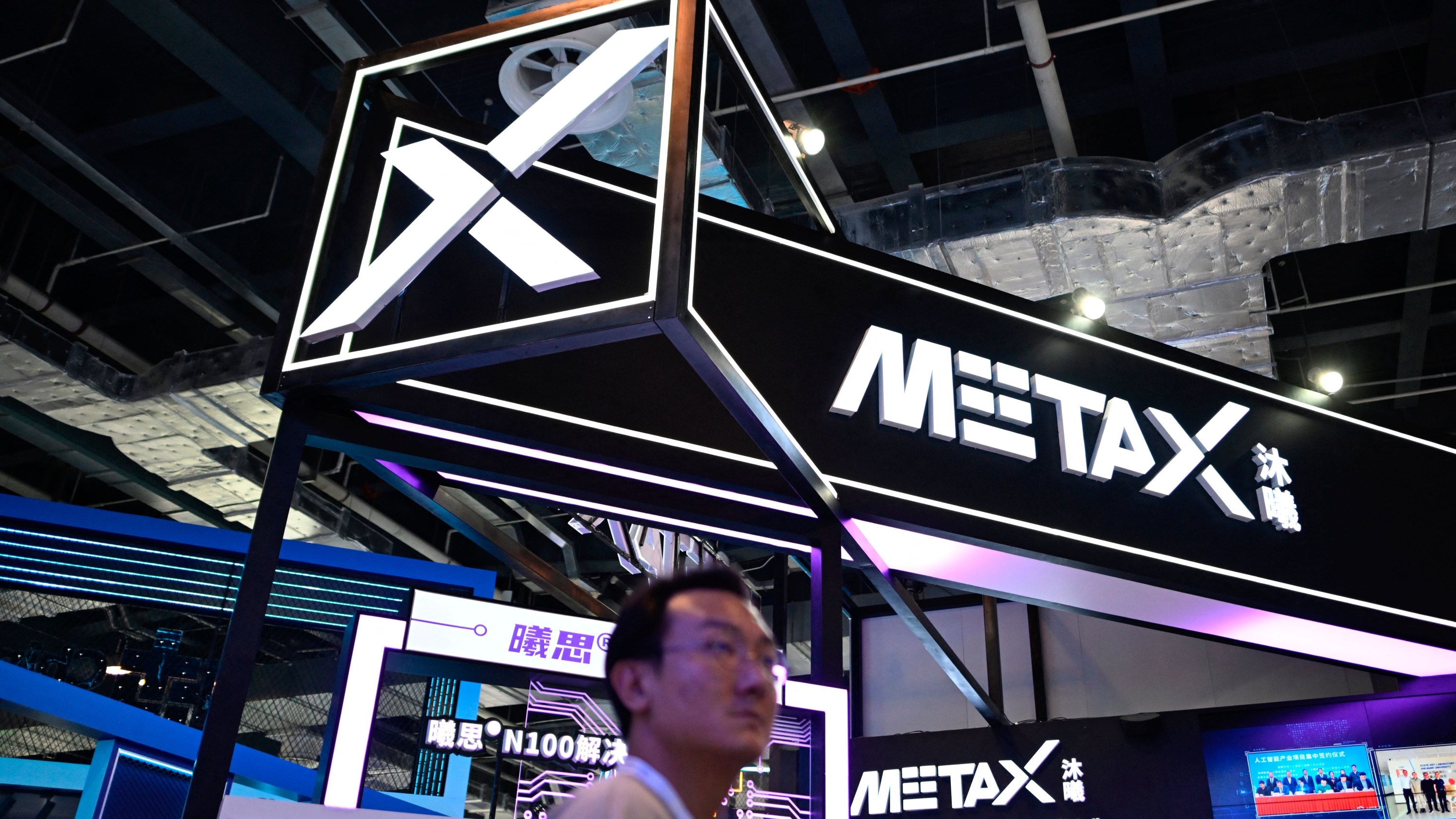

Новая модель разработана для работы на отечественных чипах от MetaX, не требуя оборудования NVIDIA. (Изображение: Getty Images | WANG ZHAO)

Особенности SpikingBrain1.0

Анализ целых предложений одновременно требует значительных ресурсов. Чем больше данных поступает на вход, тем больше вычислительной мощности требуется для их обработки. Именно поэтому современные LLM нуждаются в огромных вычислительных ресурсах. Каждое слово сравнивается с каждым другим словом, и это "съедает" много энергии.

SpikingBrain1.0, как утверждается, имитирует работу человеческого мозга, фокусируясь только на ближайших словах, подобно тому, как мы воспринимаем контекст предложения. Мозг задействует только те нейронные клетки, которые ему нужны, а не работает на полную мощность постоянно.

В результате получается более эффективный процесс. Разработчики заявляют об увеличении производительности от 25 до 100 раз по сравнению с существующими LLM. В отличие от, например, ChatGPT, эта модель должна выборочно реагировать на входные данные, снижая требования к ресурсам.

Как говорится в исследовательской работе:

"Это позволяет осуществлять непрерывное предварительное обучение с использованием менее 2 процентов данных, при этом достигая производительности, сопоставимой с основными моделями с открытым исходным кодом."

Не менее важным, особенно для Китая, является то, что модель была разработана таким образом, чтобы не зависеть от графических процессоров NVIDIA. Она была протестирована на чипе местного производства от китайской компании MetaX.

Может ли SpikingBrain1.0 указать путь к меньшему потреблению энергии для работы ИИ? (Изображение: Windows Central | Ben Wilson)

Конечно, предстоит еще многое изучить, но, по крайней мере, на бумаге, SpikingBrain1.0 может стать логичным следующим шагом в развитии LLM. Много говорилось о влиянии ИИ на окружающую среду, об огромных потребностях в энергии и о столь же огромных требованиях к охлаждению этих массивных центров обработки данных.

Уже сейчас запуск LLM дома с видеокартой RTX 5090 создает определенные неудобства. В комнате становится жарко, а с видеокартой, которая может потреблять около 600 Вт, это вряд ли можно назвать эффективным решением. А теперь представьте себе центр обработки данных, заполненный графическими процессорами!

Если все это окажется правдой, то мы станем свидетелями интересного развития. Это может стать следующим большим скачком вперед, но только если будет достигнут баланс между точностью и эффективностью. В любом случае, нас ждут захватывающие времена.

Мнение редакции MSReview: Разработка SpikingBrain1.0 выглядит многообещающе, особенно в контексте снижения энергопотребления и зависимости от западных технологий. Однако, для подтверждения заявленных преимуществ необходимы независимые тесты и сравнение с существующими LLM в реальных сценариях.

- Комментарии