Искусственный интеллект у вас дома: новое приложение Ollama упрощает запуск ИИ на вашем Windows 11 ПК

- Категория: Windows 11

- Дата: 5 августа 2025 г. в 15:45

- Просмотров: 187

Хотите пообщаться с искусственным интеллектом, не отправляя свои данные в облако? С Ollama это стало проще, чем когда-либо! Раньше для этого требовались навыки работы с командной строкой, но теперь появилось удобное приложение для Windows.

Я (автор оригинальной статьи) уже несколько месяцев экспериментирую с Ollama и считаю, что это один из самых доступных способов для обычных пользователей запускать и взаимодействовать с большими языковыми моделями (LLM) прямо на своих компьютерах.

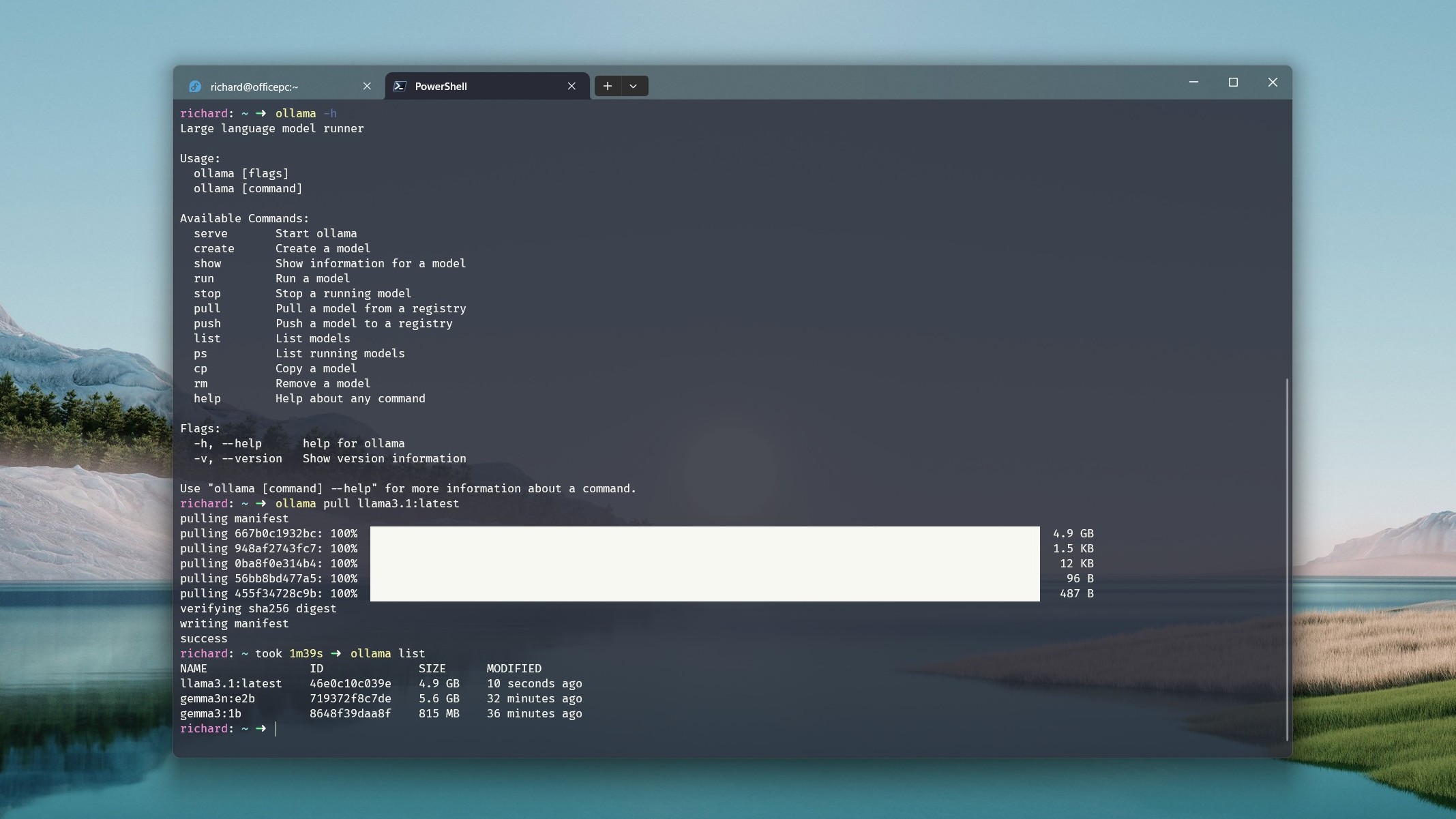

Установить и использовать Ollama и раньше не было супер-сложно, но приходилось возиться с окном терминала. Теперь же у Ollama есть классный графический интерфейс (GUI) для Windows в виде официального приложения. Оно устанавливается вместе с компонентами командной строки (CLI) и избавляет от необходимости постоянно использовать терминал для запуска ваших LLM.

Если вам больше нравится работать в терминале, вы всегда можете скачать CLI-версию Ollama из репозитория GitHub.

Установка обеих частей проста: скачиваете Ollama с веб-сайта и запускаете установщик. По умолчанию приложение работает в фоновом режиме и доступно через системный трей или через терминал. Теперь же вы можете запускать его и через меню "Пуск".

Простота в использовании

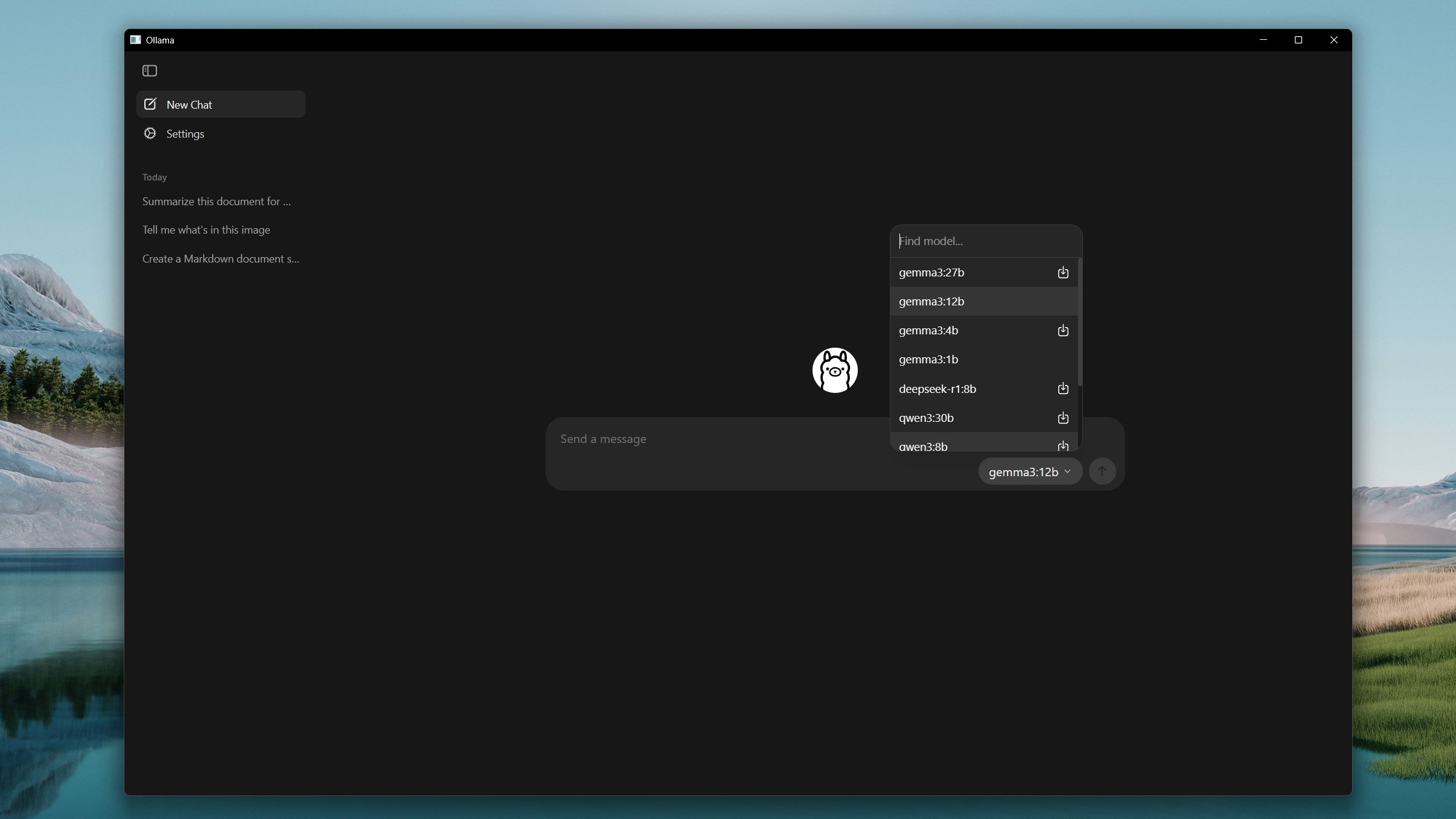

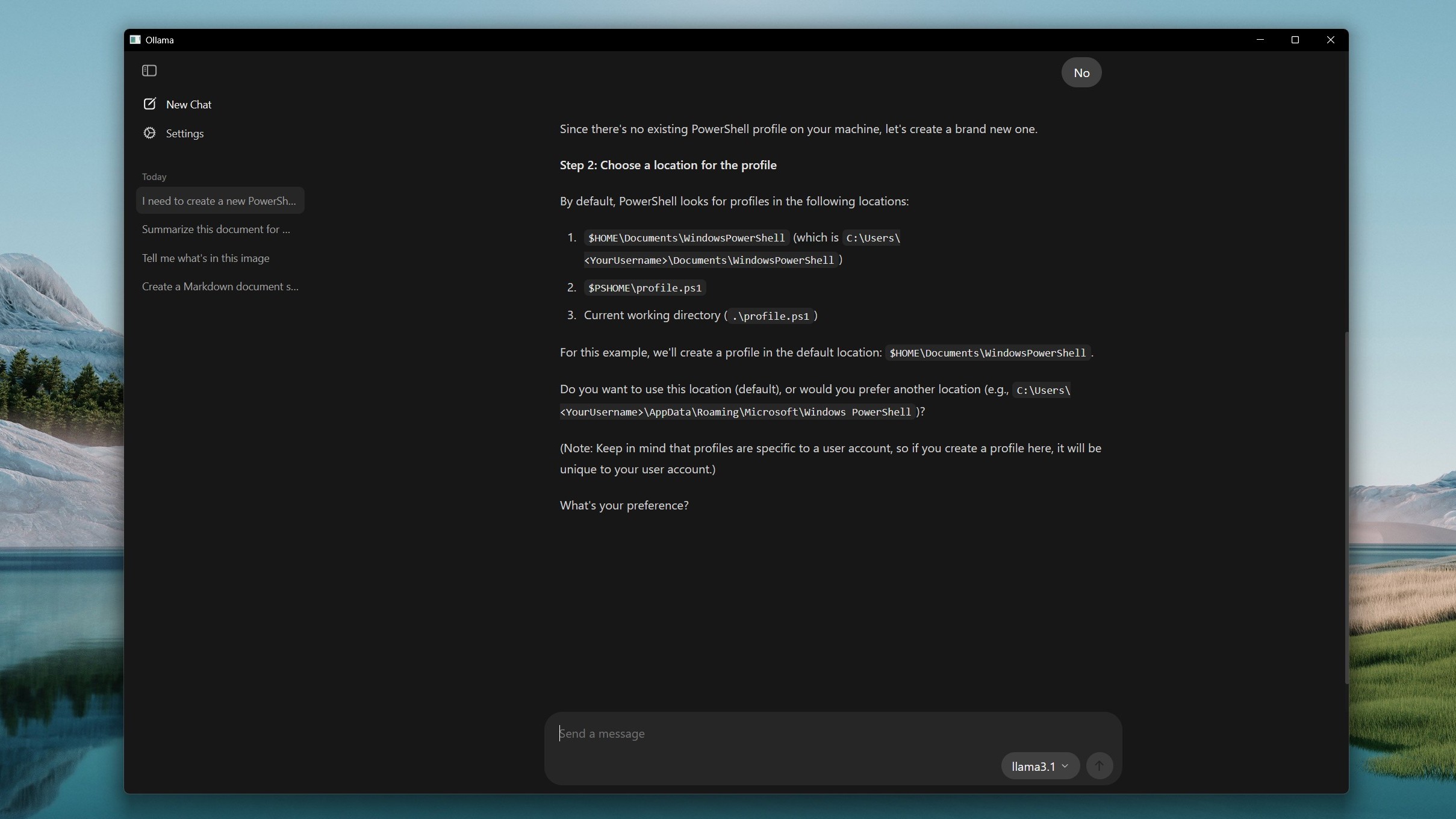

Интерфейс приложения интуитивно понятен, как и у любого чат-бота с ИИ. Вводите текст в поле, а Ollama отвечает, используя выбранную вами модель.

По идее, можно просто нажать на значок рядом с неустановленной моделью, чтобы загрузить ее на компьютер, но пока эта функция работает не всегда стабильно. Однако вы можете искать модели в выпадающем списке.

Я нашел такой обходной путь: выберите модель, а затем попробуйте отправить ей сообщение. Приложение Ollama предложит сначала загрузить ее. Конечно, вы по-прежнему можете загружать модели через терминал, и они появятся в приложении.

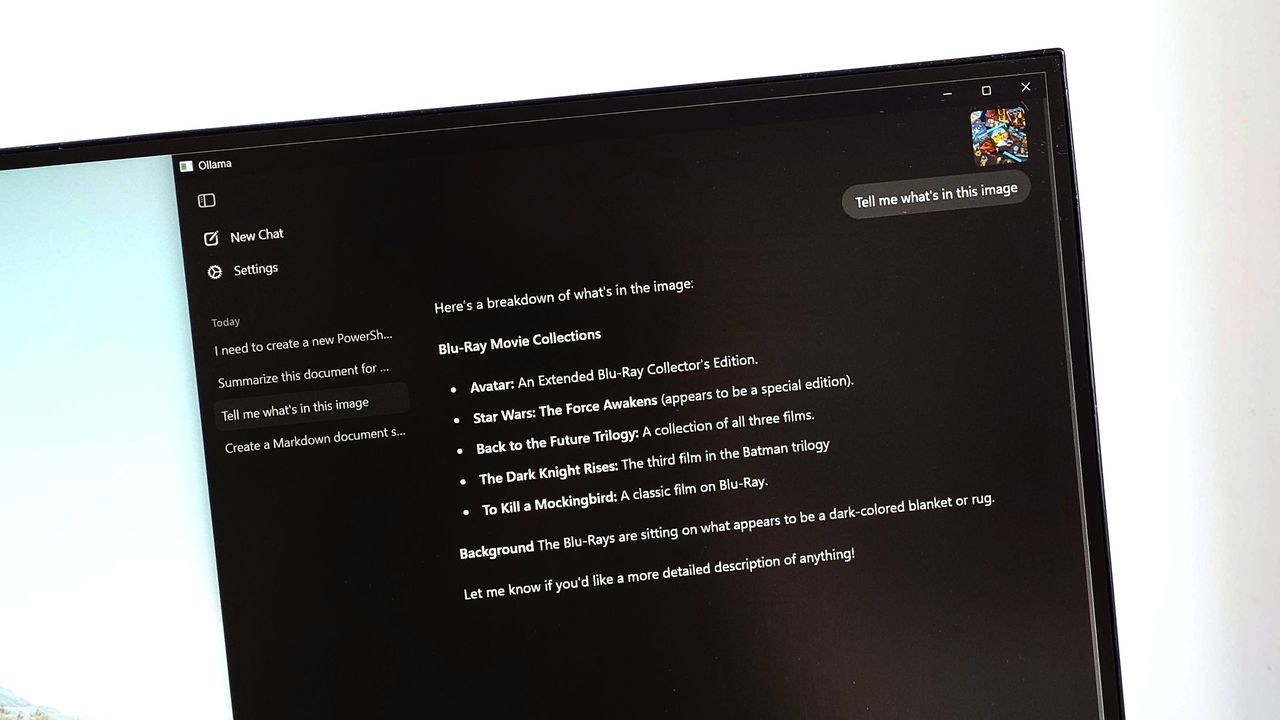

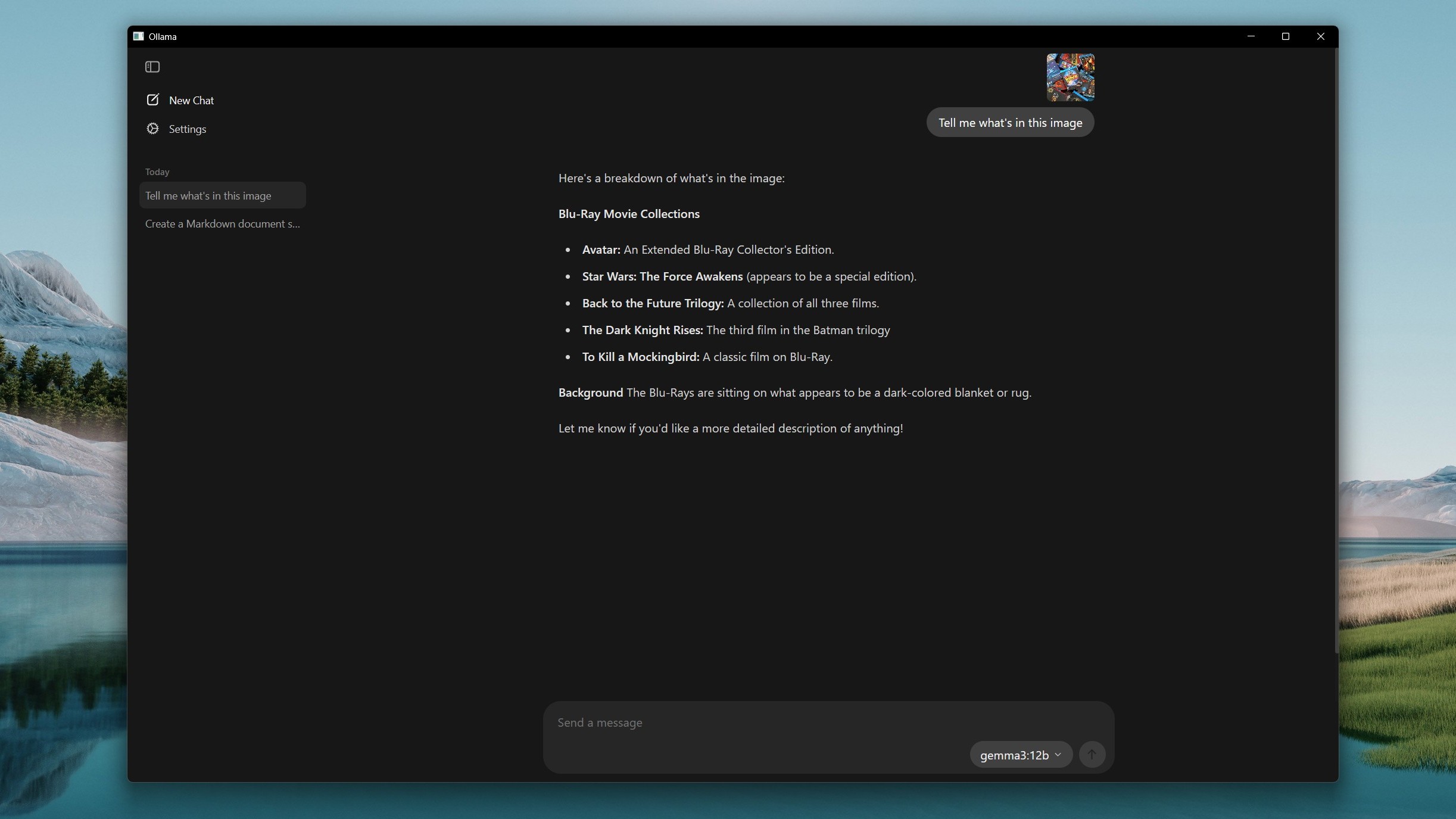

Использование Ollama и Gemma 3 для интерпретации файла изображения.(Image credit: Windows Central)

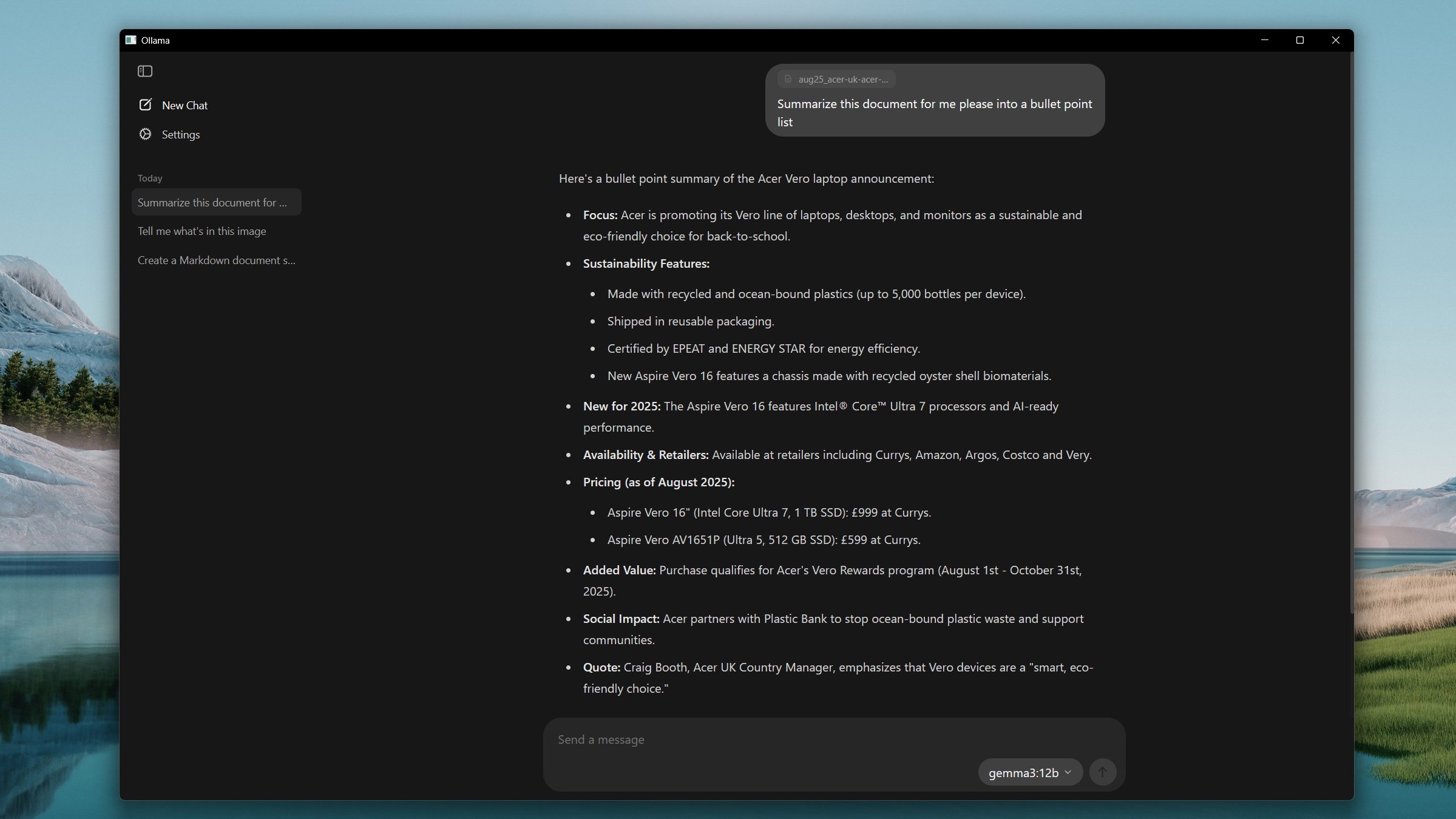

Использование Ollama и Gemma 3 для суммирования документа Microsoft Word.(Image credit: Windows Central)

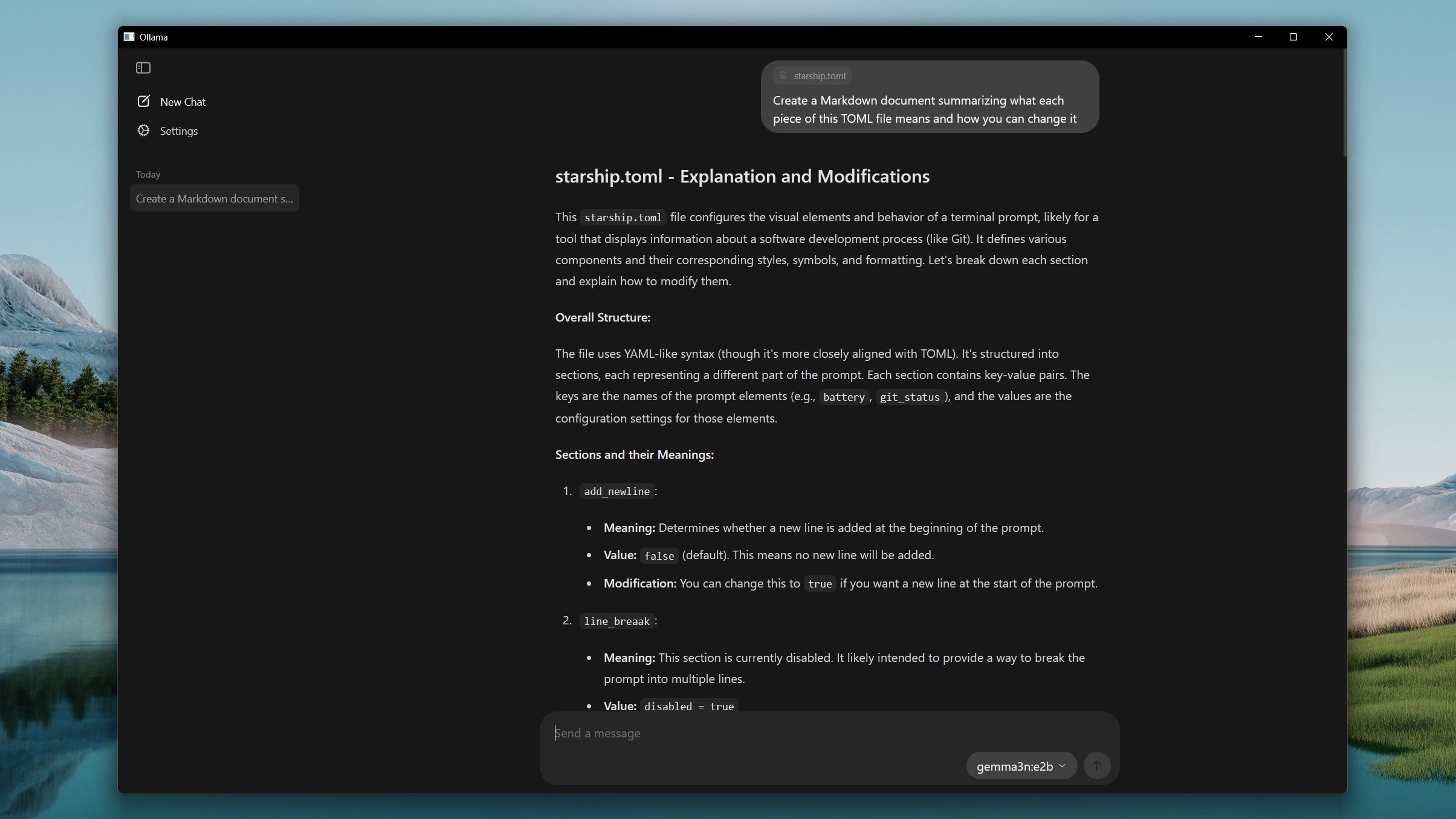

Использование Ollama для объяснения файла TOML.(Image credit: Windows Central)

Настройки

Настройки довольно простые, но одна из них позволяет изменить размер окна контекста. Если вы работаете с большими документами, увеличьте длину контекста с помощью ползунка, но учтите, что это потребует больше системной памяти.

У нового приложения Ollama есть несколько интересных функций. Благодаря поддержке мультимодальности вы можете перетаскивать изображения в приложение и отправлять их моделям, которые поддерживают их интерпретацию, например, Gemma 3.

Ollama также может интерпретировать файлы кода, которые вы перетаскиваете. Например, вы можете попросить приложение создать документ Markdown, объясняющий код и то, как его использовать.

Возможность перетаскивать файлы в Ollama, безусловно, удобнее, чем пытаться взаимодействовать с ними с помощью CLI. Вам не нужно знать местоположение файлов.

По крайней мере, на данный момент, вам все равно может потребоваться использовать CLI для некоторых других функций, доступных в Ollama. Например, вы не можете загрузить модель с помощью приложения, только CLI. То же самое касается создания моделей, перечисления запущенных моделей, копирования и удаления.

Однако для общего использования я думаю, что это большой шаг вперед. Конечно, многие из тех, кто до этого момента использовали локальные LLM, вероятно, чувствуют себя комфортно в окне терминала. И использование терминала и получение удовольствия от его использования, безусловно, навык, который я всегда рекомендую.

Но наличие удобного графического интерфейса делает его более доступным для всех. Были сторонние инструменты, такие как Open WebUI, которые делали это раньше, но встроенный в пакет делает его проще.

Однако остается то, что вам все равно понадобится ПК с достаточной мощностью для использования этих моделей. Ollama пока не поддерживает NPU, поэтому вы полагаетесь на остальную часть своей системы.

Рекомендуется иметь как минимум процессор Intel 11-го поколения или процессор AMD на базе Zen 4 с поддержкой AVX-512 и в идеале 16 ГБ ОЗУ. 8 ГБ — это минимальный объем, который Ollama рекомендует для моделей 7B, и есть модели меньшего размера, которые будут использовать еще меньше ресурсов.

Вам не нужен графический процессор, но если он у вас есть, вы, естественно, получите лучшую производительность. Если вы хотите использовать некоторые из самых больших моделей, это определенно то, что вам захочется. И чем больше VRAM, тем лучше.

Запуск локальной LLM — это то, что стоит попробовать хотя бы раз, если ваш компьютер может с этим справиться. Вы не полагаетесь на веб-соединение, поэтому можете использовать его в автономном режиме, и вы также не подпитываете большой облачный компьютер ИИ в небе.

У вас нет веб-поиска "из коробки", но есть способы это настроить, если вам это абсолютно необходимо. Но вам понадобится что-то другое, чем приложение Ollama, чтобы это сделать. Просто скачайте его, попробуйте, и вы, возможно, найдете свой новый любимый чат-бот с ИИ.

Мнение редакции MSReview: Новое приложение Ollama - это большой шаг вперед для тех, кто хочет использовать локальные LLM. Графический интерфейс делает его более доступным для широкой аудитории, а возможность перетаскивать файлы - это значительное улучшение по сравнению с использованием CLI. Однако, для максимальной производительности, вам все равно понадобится мощный компьютер.

- Комментарии