Ollama в WSL: нужна ли Linux, если есть Windows?

- Категория: Windows 11

- Дата: 3 сентября 2025 г. в 17:50

- Просмотров: 215

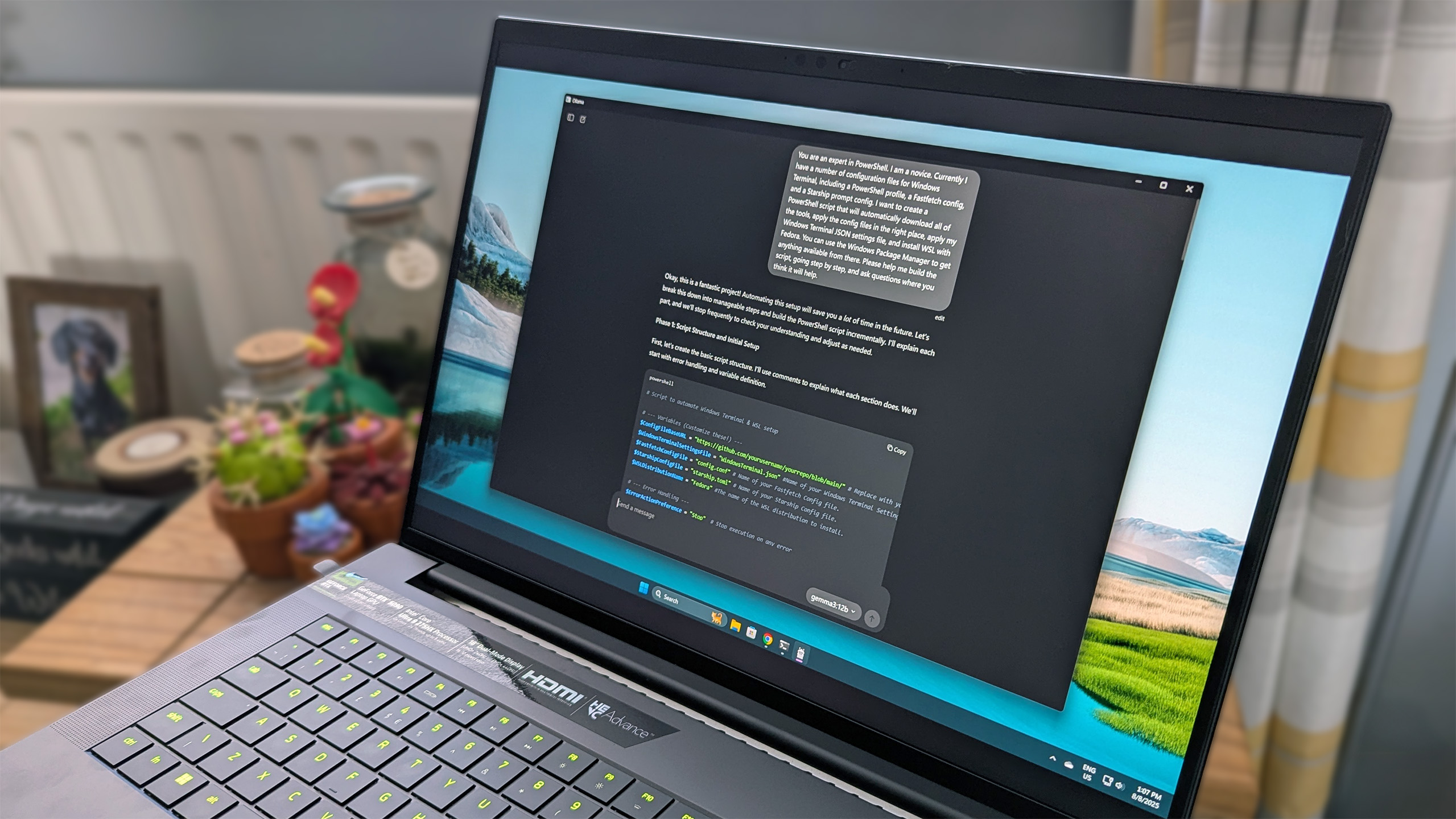

Если вы хотите использовать Ollama на своем компьютере для запуска локальных LLM (больших языковых моделей), то на ПК с Windows у вас есть два варианта. Первый — просто использовать приложение Windows и запускать его напрямую. Второй — запустить версию Linux через WSL (подсистема Windows для Linux).

Первый вариант, безусловно, проще. Вам не нужно устанавливать WSL, и сам процесс запуска элементарен: скачиваете установщик Windows, запускаете его – и готово!

Установка Ollama на WSL потребует чуть больше усилий. Но, используя Ubuntu, все проходит гладко, и производительность отличная, особенно с графическим процессором NVIDIA. Однако, если вы не разработчик, использующий WSL в своей работе, особого смысла выбирать этот путь вместо обычной версии Windows нет.

Настройка Ollama в WSL

Сразу оговорюсь, это не подробная инструкция по установке, а скорее указание направления. Чтобы использовать Ollama на WSL (особенно на Ubuntu, как наиболее простой и хорошо документированной системе), потребуется соблюсти несколько предварительных условий. Этот пост также относится к графическим процессорам NVIDIA.

Во-первых, вам понадобится обновленный драйвер NVIDIA для Windows. Во-вторых, специальный набор инструментов CUDA для WSL. Если у вас есть и то, и другое, все заработает как по волшебству. Подробные инструкции лучше всего искать в документации Microsoft и NVIDIA.

Процесс не займет много времени, но скорость загрузки необходимых компонентов зависит от вашего интернет-соединения.

После этого вы можете просто запустить скрипт установки Ollama. Важно: я не изучал запуск Ollama в контейнере на WSL. Мой опыт ограничивается простой установкой непосредственно в Ubuntu.

В процессе установки скрипт должен автоматически обнаружить графический процессор NVIDIA, если все настроено правильно. Во время работы скрипта вы должны увидеть сообщение "NVIDIA GPU installed" (GPU NVIDIA установлен).

Дальше все происходит так же, как и при использовании Ollama на Windows, за исключением графического приложения. Загрузите свою первую модель, и можно начинать! Однако есть один нюанс, если вы переключитесь обратно на Windows.

Если WSL запущена в отдельной вкладке, Ollama в Windows (по крайней мере, в терминале) будет распознавать только те модели, которые вы установили на WSL. Если вы выполните команду ollama --list, вы не увидите ни одной модели, установленной на Windows. Если вы попытаетесь запустить известную модель, Ollama выйдет и начнет загружать ее заново.

В этом случае перед использованием Ollama на Windows необходимо убедиться, что WSL правильно завершена. Это можно сделать, введя wsl --shutdown в терминале PowerShell.

Практически идентичная производительность в WSL и Windows

Через минуту я приведу некоторые цифры, но сначала нужно учесть один момент. Возможно, это не имеет большого значения, но следует помнить, что запуск WSL использует часть системных ресурсов.

Вы можете легко установить объем оперативной памяти и потоков ЦП, которые должна использовать WSL, в приложении настроек WSL. Если вы в основном используете графический процессор, это менее важно. Но если вы собираетесь использовать модели, которые не помещаются полностью в видеопамять, вам необходимо убедиться, что вы выделили достаточно ресурсов для WSL, чтобы это компенсировать.

Помните, если модель не помещается в видеопамять, Ollama задействует обычную системную память, а вместе с ней и ЦП. Убедитесь, что вы выделили ресурсы соответствующим образом.

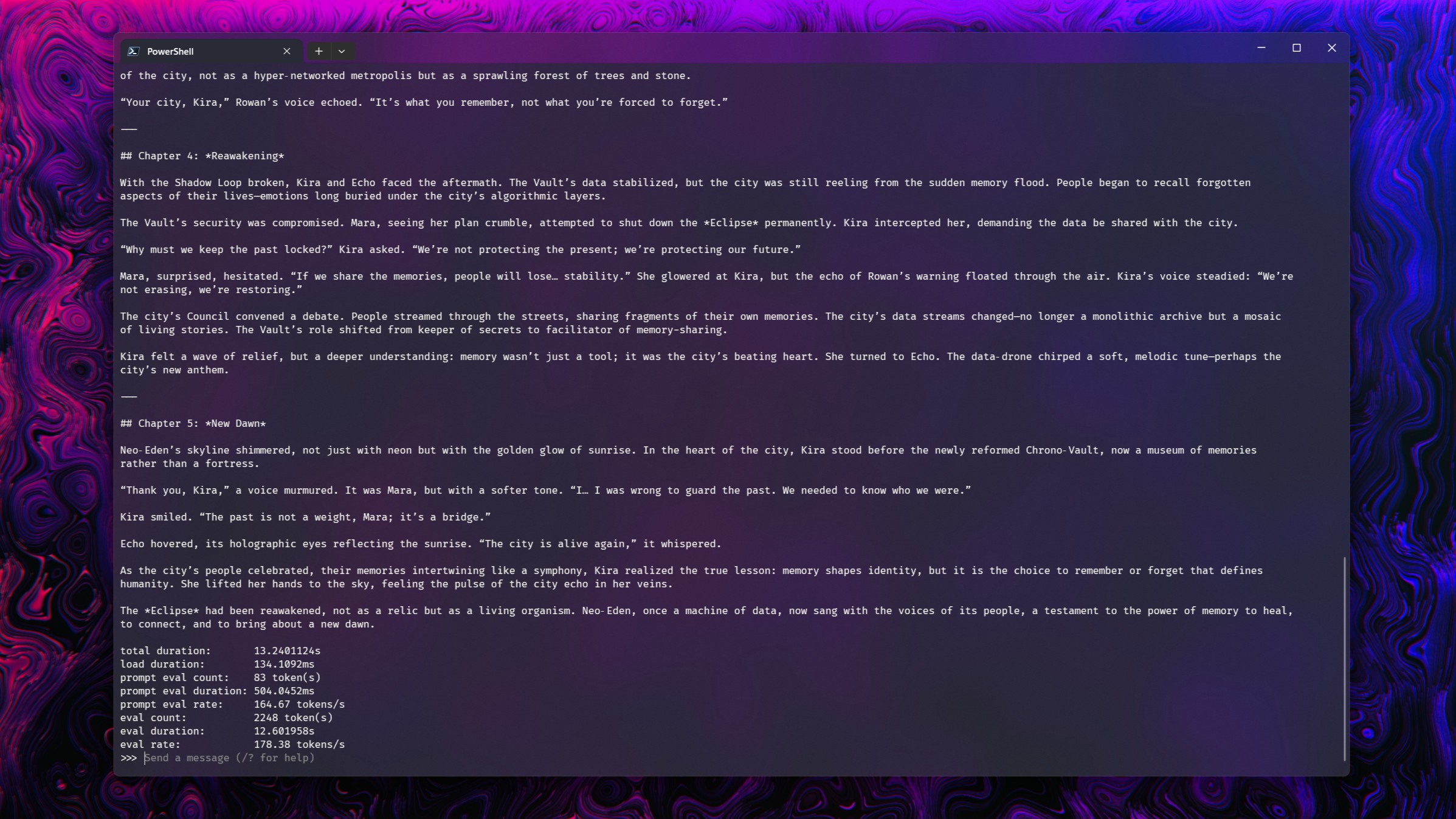

Признаюсь, эти тесты очень простые, и я не проверяю точность вывода. Они предназначены только для демонстрации сопоставимой производительности. Я рассмотрел четыре модели, которые комфортно работают на RTX 5090: deepseek-r1:14b, gpt-oss:20b, magistral:24b и gemma3:27b.

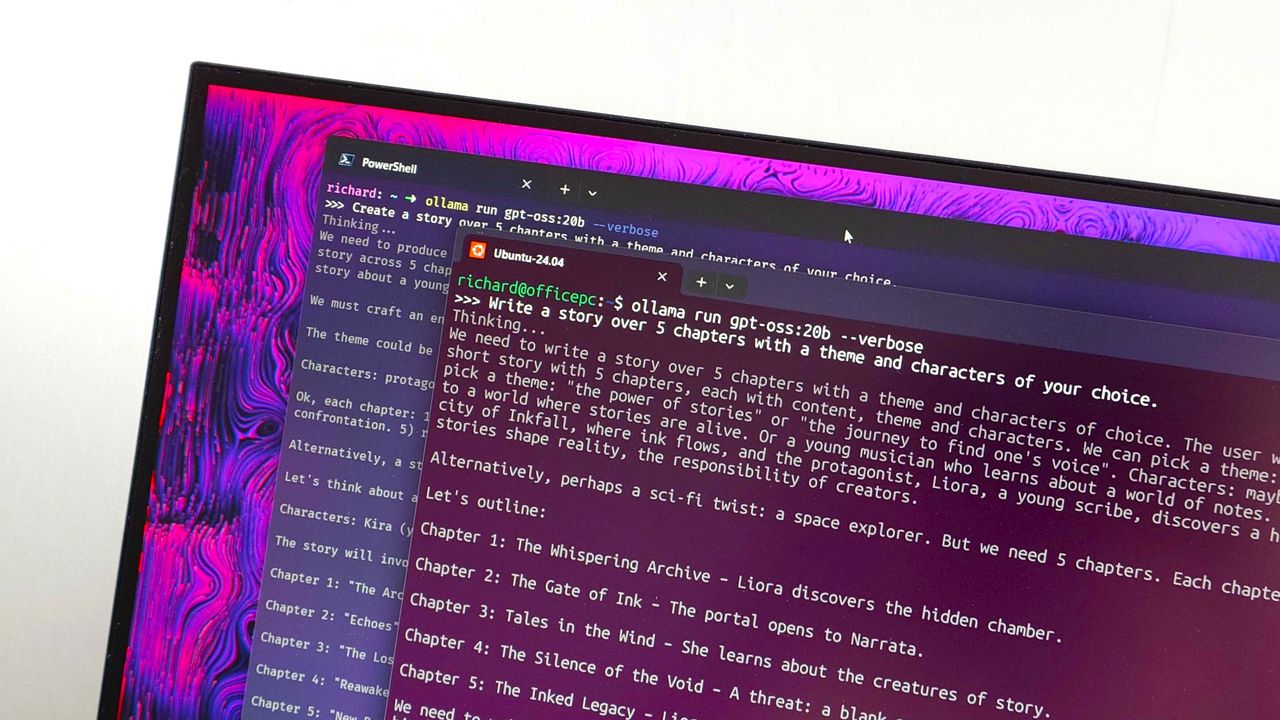

В каждом случае я задавал моделям два вопроса:

- Напишите рассказ из 5 глав на тему и с персонажами по вашему выбору. (История)

- Я хочу, чтобы вы создали клон Pong полностью на Python. Не используйте никаких внешних ресурсов, и любые графические элементы должны быть созданы внутри кода. Убедитесь, что все необходимые зависимости импортированы. (Код)

Результаты:

| WSL | Windows 11 | |

|---|---|---|

| gpt-oss:20b | История: 176 токенов/сек | История: 176 токенов/сек |

| Код: 177 токенов/сек | Код: 181 токенов/сек | |

| magistral:24b | История: 78 токенов/сек | История: 79 токенов/сек |

| Код: 77 токенов/сек | Код: 73 токенов/сек | |

| deepseek-r1:14b | История: 98 токенов/сек | История: 101 токенов/сек |

| Код: 98 токенов/сек | Код: 102 токенов/сек | |

| gemma3:27b | История: 58 токенов/сек | История: 58 токенов/сек |

| Код: 57 токенов/сек | Код: 58 токенов/сек |

Наблюдаются незначительные колебания, но в целом производительность практически идентична.

Единственное различие в воздействии на системные ресурсы заключается в дополнительной оперативной памяти, используемой, когда WSL активна. Но поскольку ни одна из этих моделей не превышала выделенную видеопамять, это не повлияло на производительность.

Ollama в WSL: мощный инструмент для разработчиков

Обычным пользователям (даже тем, кто любит WSL), не стоит беспокоиться об использовании Ollama таким образом. Я использую Ollama в основном в образовательных целях, как инструмент обучения и изучения принципов его работы.

Для этого вполне достаточно использовать его на Windows 11, либо в терминале, либо подключенным к расширению браузера Page Assist, с которым я недавно экспериментировал.

Но WSL — это мост между Windows и Linux для разработчиков. Те, у кого есть необходимые рабочие процессы WSL, могут использовать Ollama таким образом без какой-либо потери производительности.

До сих пор кажется чудом, что можно запускать Linux на Windows и полноценно использовать свой графический процессор NVIDIA. И все работает именно так, как и должно.

Мнение редакции MSReview: Ollama предоставляет интересную возможность для работы с большими языковыми моделями локально. Хотя установка через WSL может потребовать дополнительных шагов, производительность остается на уровне нативной версии Windows, что особенно ценно для разработчиков, работающих в экосистеме WSL. Выбор между нативной установкой и WSL зависит от ваших потребностей и рабочего процесса.

- Комментарии